Anhang II – Beispiele für europäische Patentanmeldungen

|

Eine revidierte Fassung dieser Publikation ist in Kraft getreten. |

Richtungs-Berührungs-Fernbedienung

Erfindungsbezeichnung (Angabe im Erteilungsantrag genügt)

Die vorliegende Technologie betrifft Fernbedienungen und insbesondere Fernbedienungen für Berührungsgeräte.

R. 42 (1) a)

Technisches Gebiet, auf das sich die Erfindung bezieht

EINFÜHRUNG

Mit der wachsenden Komplexität der Geräte werden auch die zugehörigen Fernbedienungen immer komplexer. Die ersten Fernbedienungen waren aufgrund ihrer Einfachheit effektiv, doch mit fortschreitender Technologie mangelte es ihnen an Funktionalität. Heute sind Fernbedienungen mit mehr als fünfzig Tasten gebräuchlich, wobei häufig jede Taste mehrere Funktionen hat. Solche Fernbedienungen erfordern vom Nutzer oft eine intensive Beschäftigung mit dem Gerät, um die Funktion einer Taste zu erlernen, und oft sind die Tasten so klein, dass allzu häufig Befehle versehentlich eingegeben werden.

Tasten sind praktisch, weil sie bei der Eingabe eines Befehls eine taktile Rückmeldung geben. In einigen Fällen können bestimmte ausgewählte Tasten sogar eine unterschiedliche Anmutung oder Form haben, damit die Fernbedienung mit minimaler visueller Bestätigung, ob die richtige Taste ausgewählt wurde, betätigt werden kann. Allzu häufig wird jedoch selbst bei Formen oder Texturen die Aufmerksamkeit des Nutzers vom ferngesteuerten Gerät auf die Fernbedienung gelenkt, was eine unerwünschte Folge einer komplizierten Benutzerschnittstelle ist.

Mit Touchscreen-Fernbedienungen wird versucht, einige dieser Probleme zu lösen, doch können dabei wieder andere Probleme geschaffen werden. Bei Touchscreen-Fernbedienungen ist es zwar möglich, weniger Optionen gleichzeitig auf dem Bildschirm anzuzeigen (der Nutzer muss durch Menüs navigieren, um den richtigen Befehl zu finden), doch musste der Nutzer bei Touchscreens schon immer auf die Fernbedienung schauen. Da Touchscreens dem Nutzer keine taktile Rückmeldung zu seiner Auswahl geben, muss er die Auswahl visuell bestätigen, was unerwünscht ist.

R. 42 (1) b)

Angabe des bisherigen Stands der Technik

Andere Touchscreen-Fernbedienungen sind anwendungsspezifisch und erfordern eine Zweiwegekommunikation, bei der das ferngesteuerte Gerät die Fernbedienung anweist, eine bestimmte grafische Benutzerschnittstelle anzuzeigen. Der Nutzer muss die Fernbedienung zur Vornahme einer Auswahl ansehen, weil sich die Schnittstelle der Fernbedienung je nach Kontext der Anzeige des ferngesteuerten Geräts ändert. Diese Fernbedienungen haben außerdem den Nachteil, dass sie wegen der wechselseitigen Kommunikation zwischen der Fernbedienung und dem ferngesteuerten Gerät manchmal zu langsam für eine Fernanwendung sind.

Wieder andere Touchscreen-Fernbedienungen steuern einen Cursor, der auf dem ferngesteuerten Gerät angezeigt wird. Zwar können diese Fernbedienungen bedient werden, indem der Nutzer auf das ferngesteuerte Gerät statt auf die Fernbedienung selbst sieht, doch kann es für den Nutzer zu aufwendig sein, einen Befehl einzugeben. Der Nutzer muss mühsam einen Cursor zu einem Menü navigieren, um den Befehl auszuwählen. Diese Art von Interaktion ist weit entfernt von den Vorteilen früherer Fernbedienungen, bei denen die Steuerung durch eine einfache Tastenbedienung erfolgte.

Daher ist eine einfache Fernbedienung wünschenswert, die bedient werden kann, ohne dass der Nutzer ihr Display ansehen muss, die schnell und effizient ist und gleichzeitig das Risiko versehentlicher Befehlseingaben minimiert.

In US2008/0284726 wird eine Vorrichtung zur sensorischen Mediensteuerung beschrieben, die eine Medienvorrichtung mit einem Steuerungselement enthält, die von einer Mediensteuerung einen ersten Befehl erhält, um durch physische Betätigung der Mediensteuerung ein Objekt auszuwählen, und dann einen zweiten Befehl, um das ausgewählte Objekt zu steuern oder durch berührungslose Fingerbewegungen eine Suche auf dem Objekt durchzuführen.

US2008/0059578 betrifft ein elektronisches Kommunikationssystem mit Gestenerkennung, das die Nutzer über Gesten anderer Nutzer informiert, die an einer Kommunikationssitzung teilnehmen. Das System erfasst eine dreidimensionale Bewegung eines ersten Nutzers aus der Gruppe der Nutzer, die an einer elektronischen Kommunikationssitzung teilnehmen, wobei die dreidimensionale Bewegung bestimmt wird, indem mindestens ein Bilderfassungsgerät auf den ersten Nutzer gerichtet ist. Ausgehend von der erfassten Bewegung, identifiziert das System einen dreidimensionalen Objekteigenschaftsstrom und dann eine bestimmte elektronische Kommunikationsgeste, die den dreidimensionalen Objekteigenschaftsstrom darstellt, indem es den identifizierten dreidimensionalen Objekteigenschaftsstrom mit mehreren Definitionen von elektronischen Kommunikationsgesten vergleicht.

In US2007/0152976 ist ein Verfahren für die Zurückweisung einer unbeabsichtigten Berührung mit der Handfläche offenbart. In zumindest einigen der Ausführungsformen wird durch eine mit einem Display verbundene berührungsempfindliche Schnittstelle eine Berührung erkannt. Merkmale der Berührung können verwendet werden, um einen Satz von mit der Berührung verbundenen Parametern zu erzeugen. In einer Ausführungsform wird Firmware verwendet, um einen Zuverlässigkeitswert der Berührung zu bestimmen. Der Zuverlässigkeitswert und der Ort der Berührung werden an ein Softwaremodul weitergeleitet. Das Softwaremodul verwendet den Zuverlässigkeitswert und einen Aktivitätskontext, um ein Konfidenzniveau der Berührung zu bestimmen. In einer Ausführungsform kann das Konfidenzniveau eine Bewertung der Änderungen des Zuverlässigkeitswerts über einen bestimmten Zeitraum enthalten. Ist das Konfidenzniveau der Berührung zu niedrig, kann sie zurückgewiesen werden.

US2004/0218104 betrifft eine Nutzerschnittstelle für Multimedia-Center, die tragbare Nutzereingabegeräte mit Trägheitserfassung verwendet, mit denen die Auswahl von Kanälen und schnelles Navigieren im dichten Auswahlmenü möglich ist. Die extensive Nutzung der hohen Auflösung und Bandbreite solcher Nutzereingabegeräte wird mit Strategien zur Vermeidung unbeabsichtigter Eingaben und mit einer dichten und intuitiven interaktiven grafischen Anzeige kombiniert.

R. 42 (1) c)

Zu lösende technische Aufgabe

ZUSAMMENFASSUNG

Die Erfindung wird durch die beigefügten unabhängigen Ansprüche definiert. Zusätzliche Merkmale und Vorteile der hier offenbarten Konzepte sind in der folgenden Beschreibung dargelegt. Teilweise werden sie auch durch die Beschreibung nahegelegt oder können aus der Praxis der beschriebenen Technologien gelernt werden. Die Merkmale und Vorteile der Konzepte lassen sich mittels der in den beigefügten Ansprüchen herausgestellten Instrumente und Kombinationen umsetzen und erzielen. Diese und andere Merkmale der beschriebenen Technologien werden aus der folgenden Beschreibung und den beigefügten Ansprüchen klar werden oder können aus der Praxis der hier offenbarten Konzepte gelernt werden.

R. 42 (1) c)

Offenbarung der Erfindung

Die vorliegende Offenbarung beschreibt Verfahren und Anordnungen zur Fernsteuerung eines Geräts mit generischen Touchscreen-Daten durch Anzeige einer mehrere Kontexte umfassenden grafischen Benutzerschnittstelle (GUI) auf einem Anzeigegerät zur Steuerung zumindest einiger Funktionen eines Geräts. Daten, die ein Berührungsereignis charakterisieren, können empfangen und interpretiert oder in eine Liste verfügbarer Befehle übersetzt werden. Diese Befehle können eine Aktion des Geräts in Reaktion auf die Berührungsdaten bewirken, die unter Heranziehung des Kontexts der GUI interpretiert werden.

Die vorliegende Offenbarung umfasst ferner ein computerlesbares Medium zur Speicherung von Programmcode, der bewirkt, dass eine Vorrichtung mindestens die Schritte des oben und in dieser Beschreibung erläuterten Verfahrens durchführt.

In einigen Fällen kann dasselbe Berührungsereignis in mehreren GUI-Kontexten ein und dieselbe Aktion bewirken, in anderen Fällen jedoch unterschiedliche Aktionen in unterschiedlichen Schnittstellenkontexten.

Jedes tragbare elektronische Gerät kann als Fernbedienung verwendet werden, einschließlich eines Mobiltelefons, Smartphones, PDAs oder tragbaren Media Players.

Ebenso kann mit der Fernbedienung eine beliebige Zahl von Geräten gesteuert werden, so z. B. ein Multimedia‑Verwaltungsprogramm und ein Abspielgerät oder ein digitaler Videorekorder oder ein Fernsehempfänger, wie ein Fernseher oder eine Kabelbox.

Ebenfalls offenbart ist ein Multifunktionsgerät, das eine Anwendung ausführt, die bewirkt, dass das Multifunktionsgerät als Fernbedienung funktioniert. Bereitgestellt wird ein Touchscreen-Gerät, das eine grafische Benutzerschnittstelle mit einem unstrukturierten berührungsempfindlichen Bereich anzeigt. Der Touchscreen kann so konfiguriert sein, dass er im unstrukturierten berührungsempfindlichen Bereich verschiedene Arten von Eingaben in Form von Berührungsgesten empfangen und die Gesten in elektronische Signale umwandeln kann, wobei der unstrukturierte berührungsempfindliche Bereich mindestens einen Bereich umfasst, der keine individuell auswählbaren Merkmale aufweist. Das Gerät umfasst ferner einen Prozessor zum Empfangen der elektronischen Signale vom berührungsempfindlichen Bereich und zum Übersetzen der Signale zumindest in Positions-, Bewegungs- und Dauerparameter. Außerdem wird eine Kommunikationsschnittstelle bereitgestellt, die die Parameter vom Prozessor empfängt und zur Interpretation an ein Gerät sendet, das ferngesteuert werden soll. Die Kommunikationsschnittstelle kann mindestens ein Protokoll verwenden, das im Wesentlichen unidirektional genutzt werden kann, um die Parameter an das ferngesteuerte Gerät zu senden, wobei auf der Fernbedienung keine Eingabebestätigung empfangen wird.

In einigen Ausführungsformen ist ein Verfahren zur Fernsteuerung einer Anwendung offenbart, die ausgewählt wird aus einer Vielzahl von möglichen Anwendungen auf ein und demselben oder auf mehreren verschiedenen Remote-Geräten. Daten in Form von Berührungseingaben können in einem unstrukturierten Bereich einer Touchscreen-Schnittstelle empfangen werden. Die Daten können durch ein ferngesteuertes Gerät oder ein Gerät, das eine ferngesteuerte Anwendung hostet, empfangen und in einen Satz verfügbarer Ereignisse interpretiert werden, die von diesem ferngesteuerten Gerät bzw. dieser ferngesteuerten Anwendung erkannt werden können. Basierend auf einer Reihe verfügbarer Ereignisse kann eine mit einem Kontext verknüpfte GUI aktualisiert werden. Die Aktualisierung kann in Reaktion auf die Auswahl eines Ereignisses aus dem Satz der von der ferngesteuerten Anwendung erkennbaren Ereignisse erfolgen, das basierend auf dem mit der angezeigten GUI verknüpften Kontext ausgewählt wird.

KURZE BESCHREIBUNG DER ZEICHNUNGEN

Um bestmöglich darzustellen, wie die oben beschriebenen Ausführungsformen umgesetzt werden, und um weitere Vorteile und Merkmale der Offenbarung zu definieren, folgt nachstehend eine detailliertere Beschreibung, die durch die beigefügten Zeichnungen veranschaulicht wird. Diese Zeichnungen geben nur exemplarische Ausführungsformen der Erfindung wieder und sind daher nicht als in ihrem Umfang einschränkend aufzufassen; die Beispiele werden anhand der beigefügten Zeichnungen mit zusätzlichen Angaben und Details beschrieben und erläutert:

R. 42 (1) d)

Kurze Beschreibung der Zeichnungen

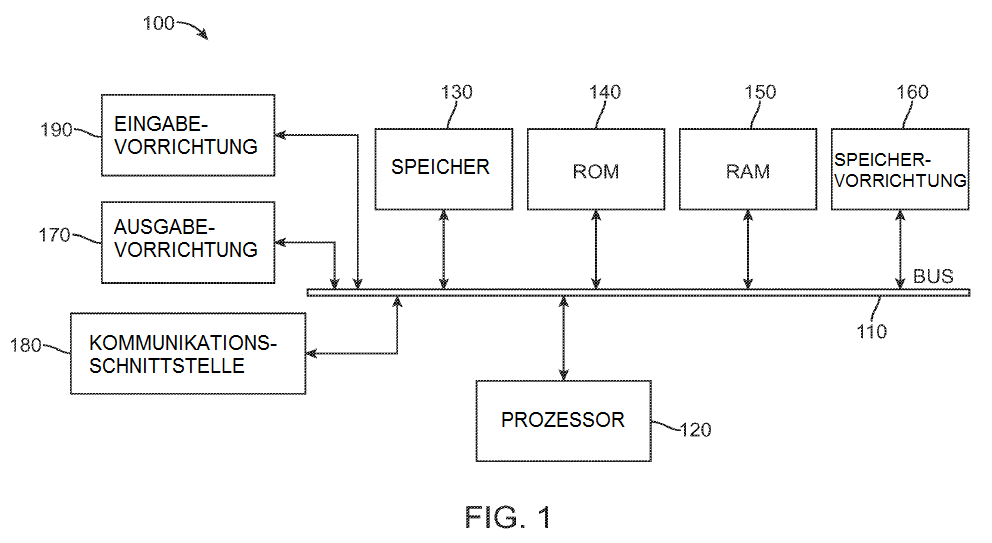

FIG. 1 zeigt ein beispielhaftes Computergerät;

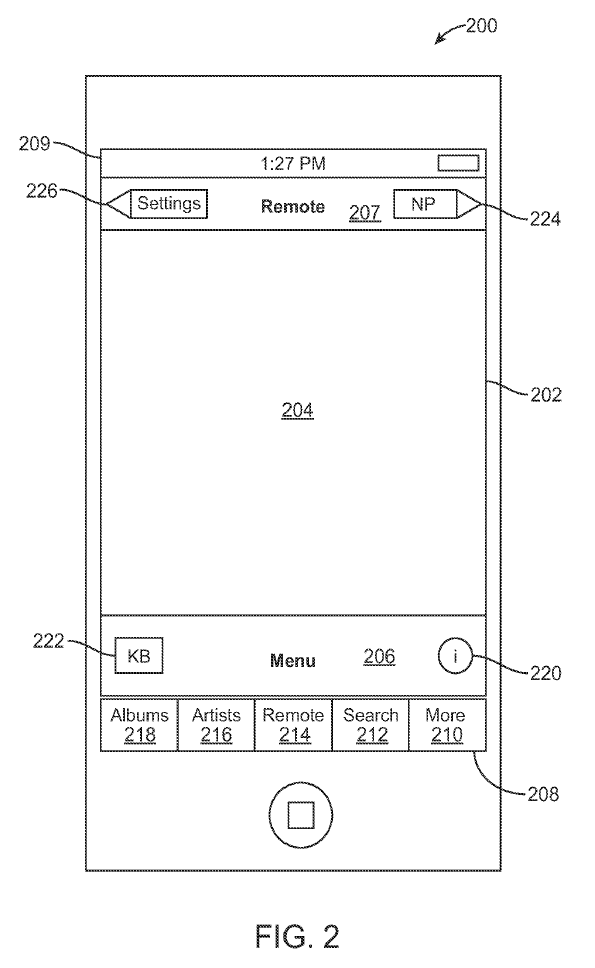

FIG. 2 zeigt eine beispielhafte Ausführungsform einer Schnittstelle für eine Fernbedienung;

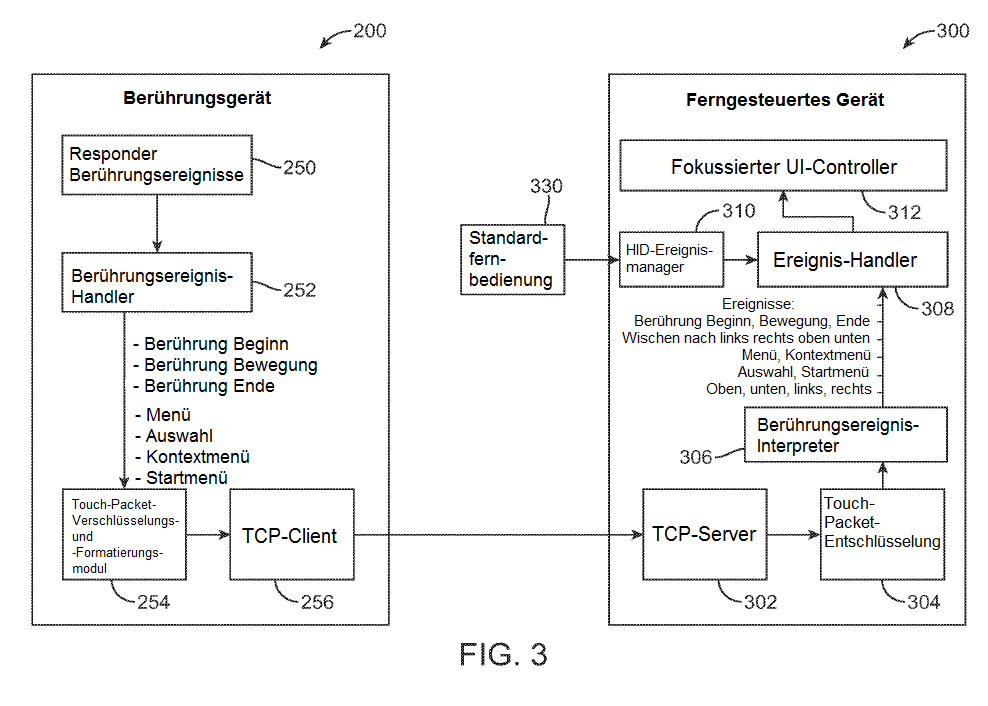

FIG. 3 zeigt eine beispielhafte Ausführungsform eines Funktionsdiagrammsystems;

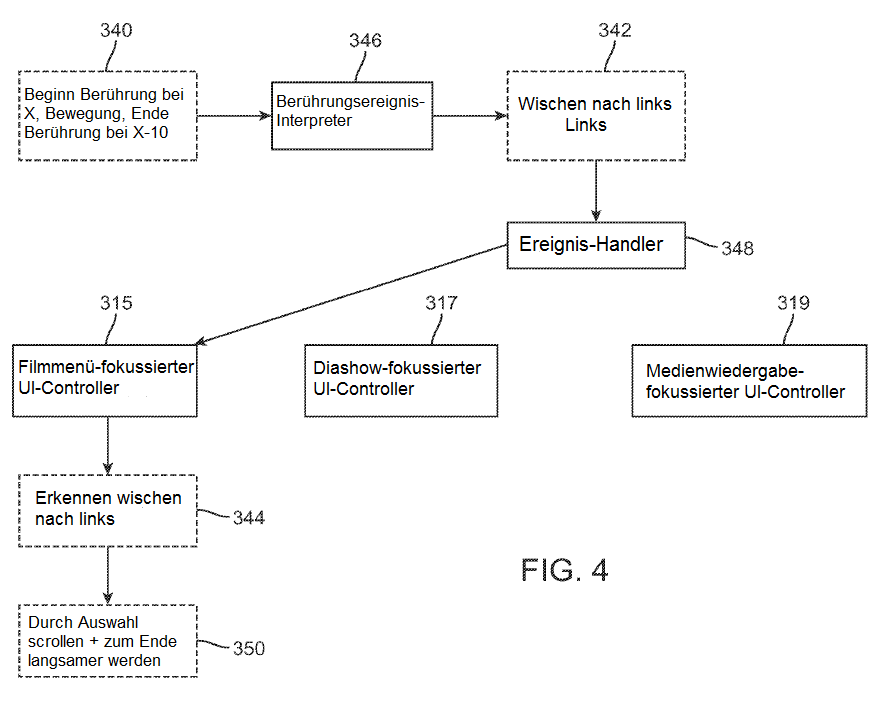

FIG. 4 zeigt eine beispielhafte Ausführungsform eines Flussdiagramms einer gezielten UI-Steuerungsfunktion;

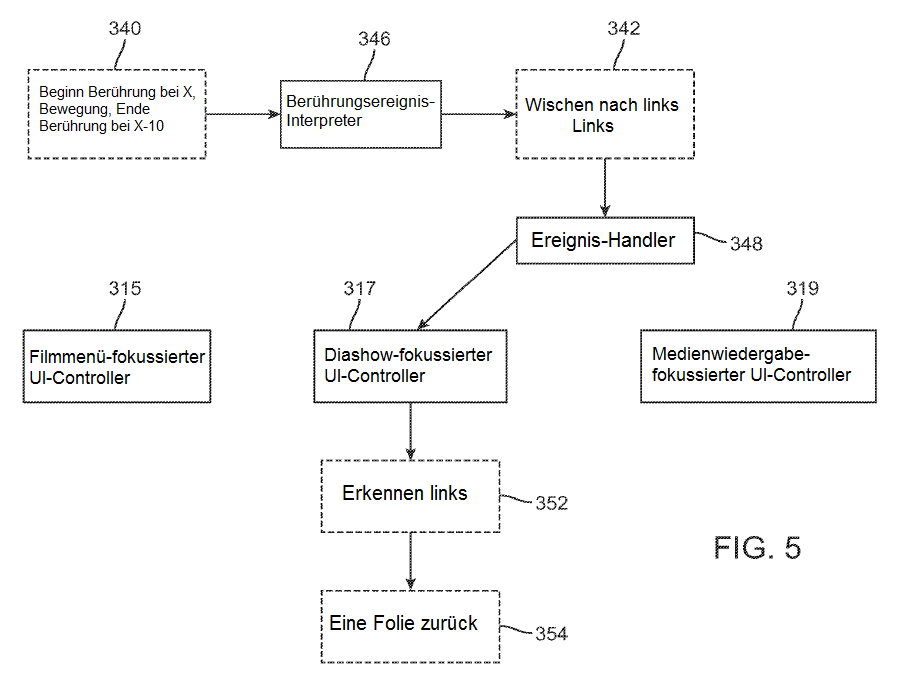

FIG. 5 zeigt eine beispielhafte Ausführungsform eines Flussdiagramms einer gezielten UI-Steuerungsfunktion;

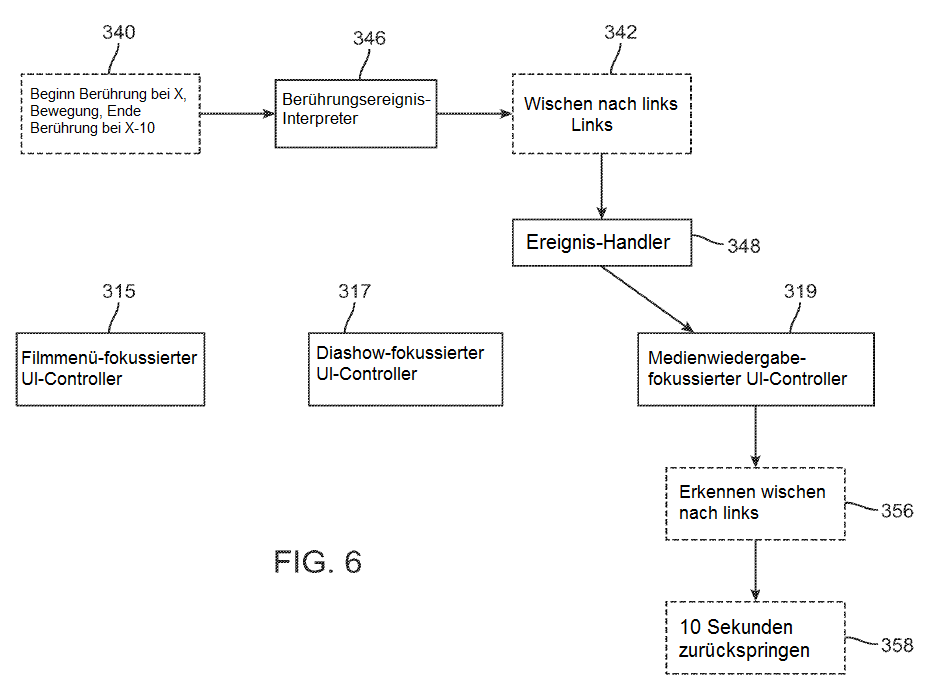

FIG. 6 zeigt eine beispielhafte Ausführungsform eines Flussdiagramms einer gezielten UI-Steuerungsfunktion;

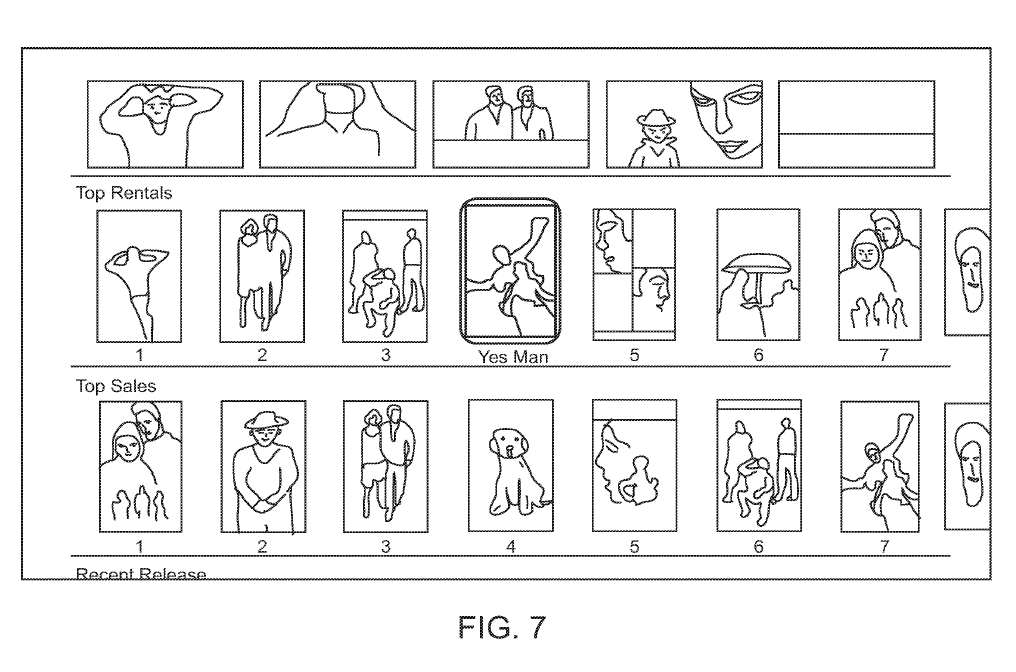

FIG. 7 zeigt eine beispielhafte Ausführungsform einer Menü-GUI;

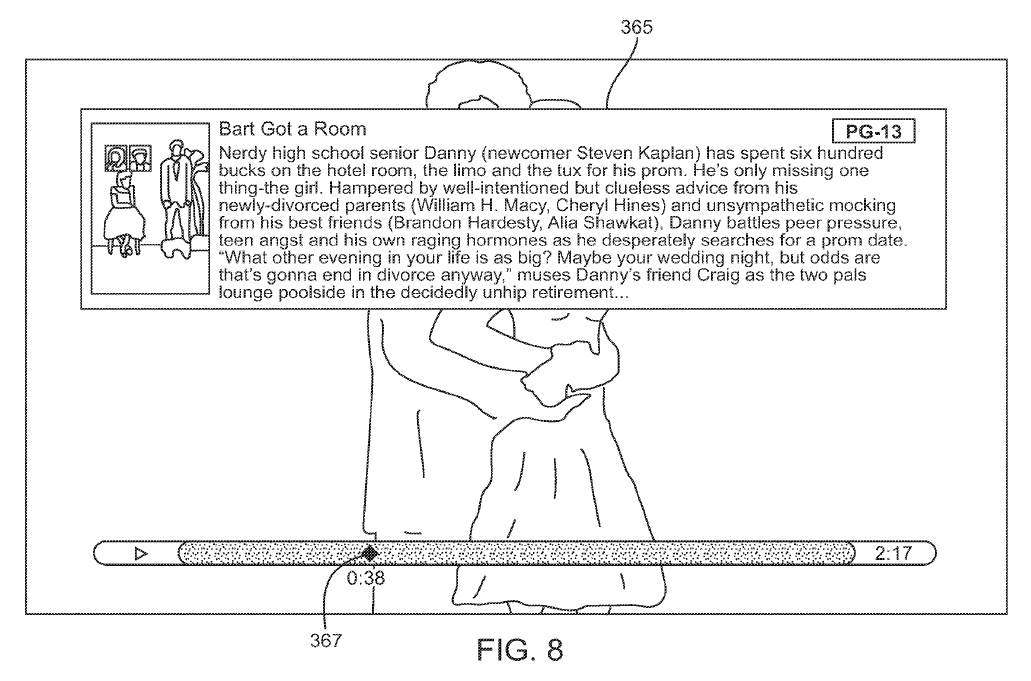

FIG. 8 zeigt eine beispielhafte Ausführungsform einer GUI mit Medienwiedergabe;

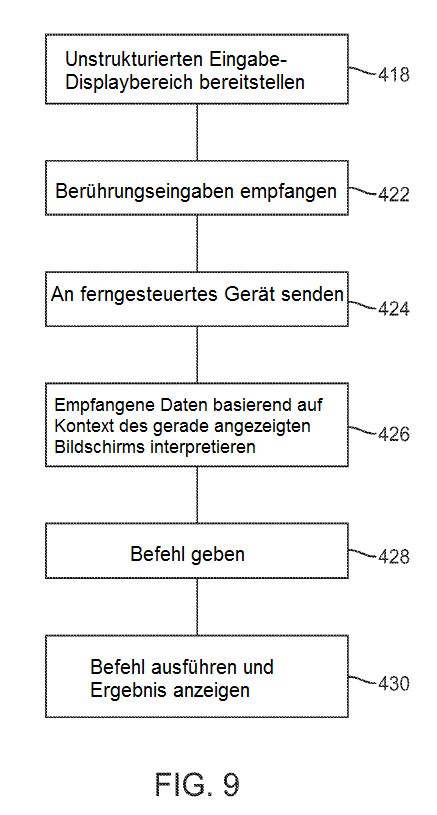

FIG. 9 zeigt eine beispielhafte Ausführungsform eines Verfahrens; und

FIG. 10 zeigt eine beispielhafte Ausführungsform einer Schnittstelle für eine Fernbedienung.

DETAILLIERTE BESCHREIBUNG

Nachstehend werden verschiedene Ausführungsformen der offenbarten Verfahren und Anordnungen ausführlich erörtert. Auch wenn spezifische Umsetzungen diskutiert werden, erfolgt dies nur zu Veranschaulichungszwecken. Ein Fachmann wird erkennen, dass andere Komponenten, Konfigurationen und Schritte verwendet werden können, ohne von der Lehre und vom Umfang der Offenbarung abzuweichen.

R. 42 (1) e)

Beschreibung wenigstens eines Wegs zur Ausführung der Erfindung

In FIG. 1 ist ein Universal-Computergerät 100 dargestellt, das tragbar oder stationär sein kann.

Das Universal-Computergerät kann dazu geeignet sein, die beschriebenen Ausführungsformen durchzuführen, oder in einigen Ausführungsformen können zwei oder mehr Universal-Computergeräte miteinander kommunizieren, um die nachstehend beschriebenen Ausführungsformen durchzuführen. Das Universal-Computergerät 100 ist dargestellt mit einer Prozessoreinheit (CPU) 120 und einem Systembus 110, über den verschiedene Systemkomponenten, einschließlich des Systemspeichers wie des Nur-Lese-Speichers (ROM) 140 und des Direktzugriffsspeichers (RAM) 150 an die Prozessoreinheit 120 gekoppelt sind. Daneben kann auch ein weiterer Systemspeicher 130 zur Nutzung verfügbar sein. Das System kann auf einem Computergerät mit mehr als einer CPU 120 oder auf einer Gruppe oder einem Cluster von Computergeräten laufen, die miteinander vernetzt sind, um eine größere Verarbeitungskapazität bereitzustellen. Der Systembus 110 kann einer von mehreren Typen von Busstrukturen sein, einschließlich eines Speicherbusses oder einer Speichersteuerung, eines Peripheriebusses und eines lokalen Busses unter Verwendung einer Vielzahl von Busarchitekturen. Eine grundlegende Eingabe/Ausgabe (BIOS), die im ROM 140 oder Ähnlichem gespeichert ist, kann die grundlegende Routine bereitstellen, die dazu beiträgt, Informationen zwischen Elementen im Computergerät 100 zu übertragen, beispielsweise während des Startvorgangs. Das Computergerät 100 umfasst ferner Speichervorrichtungen wie ein Festplattenlaufwerk 160, ein Magnetplattenlaufwerk, ein optisches Plattenlaufwerk, ein Bandlaufwerk oder Ähnliches. Die Speichervorrichtung 160 ist über eine Laufwerkschnittstelle mit dem Systembus 110 verbunden. Die Laufwerke und die zugehörigen computerlesbaren Medien stellen eine nicht flüchtige Speicherung von computerlesbaren Befehlen, Datenstrukturen, Programm-Modulen und anderen Daten für das Computergerät 100 bereit. In einer Ausführungsform umfasst ein Hardware-Modul, das eine bestimmte Funktion ausübt, die in einem greifbaren computerlesbaren Medium gespeicherte Software-Komponente in Verbindung mit den erforderlichen Hardware-Komponenten wie CPU, Bus, Display usw. zur Ausführung der Funktion. Die grundlegenden Komponenten sind dem Fachmann bekannt, und geeignete Variationen sind in Abhängigkeit vom Gerätetyp denkbar, je nachdem ob es sich z. B. um ein kleines, tragbares Computergerät, einen Desktop-Computer oder einen großen Computerserver handelt.

Obwohl die hier beschriebene exemplarische Umgebung eine Festplatte verwendet, sollte der Fachmann erkennen, dass andere Arten von computerlesbaren Medien, die für einen Computer zugängliche Daten speichern können, wie z. B. Magnetkassetten, Flash-Speicherkarten, DVDs, Kassetten, Direktzugriffsspeicher (RAM) oder Nur-Lese-Speicher (ROM), ebenfalls in dieser exemplarischen Betriebsumgebung benutzt werden können.

Damit eine Nutzerinteraktion mit dem Computergerät 100 möglich ist, steht die Eingabevorrichtung 190 stellvertretend für eine Vielzahl von Eingabemechanismen, wie etwa ein Mikrofon für Spracheingabe, einen berührungsempfindlichen Bildschirm für Gesten oder grafische Eingaben, eine Tastatur, eine Maus, Bewegungseingaben, Spracheingaben usw. Die Ausgabevorrichtung 170 steht ebenfalls für eine oder mehrere verschiedene Ausgabemechanismen, die dem Fachmann bekannt sind. Gebräuchlich sind beispielsweise Video- oder Audioausgabegeräte, die an Displays oder Lautsprecher angeschlossen werden oder diese enthalten können. Daneben können die Video- und die Audioausgabegeräte auch spezielle Prozessoren für die verbesserte Leistung dieser speziellen Funktionen enthalten. In einigen Fällen ermöglichen multimodale Systeme einem Nutzer, verschiedene Eingabetypen zur Kommunikation mit dem Computergerät 100 zu verwenden. Die Kommunikationsschnittstelle 180 regelt und verwaltet allgemein die Nutzereingaben und die Systemausgaben. Es gibt keine Beschränkung für die offenbarten Verfahren und Geräte, die auf irgendeiner Hardware-Anordnung laufen, weshalb die grundlegenden Merkmale im Zuge der Entwicklung leicht durch verbesserte Hardware- oder Firmware-Anordnungen ersetzt werden können.

Zur besseren Veranschaulichung wird die beispielhafte Ausführungsform des Systems mit einzelnen Funktionsblöcken (einschließlich als "Prozessor" bezeichneter Funktionsblöcke) dargestellt. Die Funktionen, für die diese Blöcke stehen, können durch die Verwendung von gemeinsam genutzter oder dedizierter Hardware bereitgestellt werden, einschließlich, aber nicht beschränkt auf Hardware, die Software ausführen kann. Beispielsweise können die Funktionen eines oder mehrerer Prozessoren gemäß FIG. 1 durch einen gemeinsam genutzten Prozessor oder durch mehrere Prozessoren bereitgestellt werden. (Die Verwendung des Begriffs "Prozessor" ist nicht so auszulegen, dass sie sich ausschließlich auf Hardware bezieht, die Software ausführen kann.) Beispielhafte Ausführungsformen können umfassen: Mikroprozessor- und/oder Digitalsignalprozessor(DSP)-Hardware, Nur-Lese-Speicher (ROM) zur Speicherung von Software, die die nachstehend beschriebenen Operationen ausführt, und Direktzugriffsspeicher (RAM) zur Speicherung von Ergebnissen. Sehr hoch integrierte Hardware-Ausführungsformen (VLSI) sowie kundenspezifische VLSI-Schaltungen in Kombination mit einer Universal-DSP-Schaltung können ebenfalls bereitgestellt werden.

Die logischen Operationen der verschiedenen Ausführungsformen können umgesetzt werden als: (1) eine Sequenz computerimplementierter Schritte, Operationen oder Verfahren, die in einer programmierbaren Schaltung auf einem Universalcomputer laufen, (2) eine Sequenz computerimplementierter Schritte, Operationen oder Verfahren, die in einer programmierbaren Schaltung mit spezifischem Verwendungszweck laufen, und/oder (3) miteinander verbundene Maschinenmodule oder Programmmaschinen innerhalb der programmierbaren Schaltungen.

Das vorliegende System und das vorliegende Verfahren sind besonders nützlich für die Fernsteuerung eines Geräts mit einem oder mehreren Menüs über eine Fernberührungsschnittstelle, die mindestens einen unstrukturierten primären Eingabebereich aufweist. Ein Nutzer kann über eine Berührungsschnittstelle Eingaben vornehmen, ohne die Schnittstelle ansehen zu müssen, und dennoch die erwünschte Reaktion des ferngesteuerten Geräts erzielen. Der primäre Eingabebereich der Berührungsschnittstelle kann eine Hintergrundanzeige wie bei einem typischen Touchscreen aufweisen oder nicht; der primäre Eingabebereich der Berührungsschnittstelle sollte jedoch unstrukturiert sein. Mit anderen Worten sollte in bevorzugten Ausführungsformen der primäre Eingabebereich der Berührungsschnittstelle keine unabhängig auswählbaren Elemente, Tasten, Symbole oder dergleichen aufweisen. Da die Berührungsschnittstelle unstrukturiert ist, muss der Nutzer keine auswählbaren Tasten identifizieren. Stattdessen kann er eine Geste in die Schnittstelle eingeben und beobachten, wie das Gerät reagiert. In einigen Ausführungsformen liefert das System keine andere visuelle Bestätigung.

FIG. 2 zeigt eine beispielhafte Ausführungsform einer Fernbedienung. Dargestellt ist eine Fernbedienung 200, die eine Anwendung oder eine andere Softwareroutine ausführt, die die Schnittstelle bereitstellt. Auch wenn in der dargestellten Ausführungsform eine Fernbedienung 200 mit einer Touchscreen-Schnittstelle 202 gezeigt ist, kann es sich bei der Schnittstelle um eine beliebige berührungsempfindliche Schnittstelle handeln, wie z. B. ein Touchpad mit kapazitivem Sensor. Ferner kann die Fernbedienung selbst ein dediziertes Remote-Gerät oder ein tragbares elektronisches Gerät mit anderen Funktionen sein, wie etwa ein Smartphone oder ein tragbares Musikwiedergabegerät oder ein PDA.

Die berührungsempfindliche Schnittstelle 202 umfasst einen primären berührungsempfindlichen Bereich 204, der die Mehrzahl der Berührungseingaben der Nutzer empfangen kann. In der dargestellten Ausführungsform umfasst die berührungsempfindliche Schnittstelle noch weitere berührungsempfindliche Bereiche, darunter einen Menübereich 206, eine Navigationsleiste 207, eine Registerkartenleiste 208 und eine Statusleiste 209.

Der primäre berührungsempfindliche Bereich 204 ist ein unstrukturierter Bereich, der keine individuell auswählbaren Elemente wie Tasten oder Symbole aufweist. Da der Bereich 204 unstrukturiert ist, müssen auch keine auswählbaren Elemente ausgewählt oder ihre versehentliche Auswahl vermieden werden, sodass der primäre berührungsempfindliche Bereich besonders geeignet ist, um Eingaben in die Fernbedienung zu machen, ohne die Fernbedienung selbst ansehen zu müssen. Stattdessen kann der Nutzer für Rückmeldungen das ferngesteuerte Gerät ansehen.

Beginnend mit der Navigationsleiste 207 werden zwei unabhängig auswählbare Tasten angezeigt. Indem der Nutzer die Zurücktaste 226 auswählt, die hier "Einstellungen" heißt, weil in dieser exemplarischen Darstellung ein Nutzer zum Einstellungsmenü zurückkehren kann, kann er zum vorherigen Bildschirm zurückkehren. Je nach Name des Bildschirms, zu dem der Nutzer bei Auswahl der Taste zurückkehrt, kann sich die Bezeichnung der Taste ändern. Die Taste 224 fungiert als Vorwärtstaste, bringt den Nutzer aber in den meisten Fällen zu einem Bildschirm "Aktueller Titel", der angezeigt wird, wenn das ferngesteuerte Gerät Audio- oder Videomaterial wiedergibt. Hier und für das ganze Dokument gilt, dass zwar viele Tasten der Remote-Schnittstelle mit einem spezifischen Namen angegeben sind, dies aber nicht einschränkend sein soll.

Der gesamte Menübereich 206 ist ein berührungsempfindlicher Bereich, der Eingaben erfasst, um zum vorherigen Menü zurückzukehren (durch Empfangen eines Antippens im Menübereich) oder um zum Menü der obersten Ebene zurückzukehren (durch Empfangen und Erkennen eines Drückens und Gedrückthaltens). In der dargestellten Ausführungsform sind zwei weitere Tasten vorhanden. Die Tastaturtaste 222 und die Informationstaste 220 können angezeigt werden, wenn sie benötigt werden, und ausgeblendet werden, wenn sie nicht benötigt werden. Wenn z. B. auf der Nutzerschnittstelle des ferngesteuerten Geräts eine Tastatur vorhanden ist, kann die Tastaturtaste 222 erscheinen. Die Auswahl der Tastaturtaste 222 kann bewirken, dass eine Tastatur auf der Remote-Schnittstelle erscheint, um das Eintippen in die Schnittstelle des ferngesteuerten Geräts zu erleichtern. Ähnlich kann die Informationstaste 220 angezeigt werden, wenn ein Element auf der Schnittstelle des ferngesteuerten Geräts angezeigt wird, für das Informationen verfügbar sind.

Die Tasten 220 und 222 befinden sich am äußeren Rand des Menübereichs 206 und des Bildschirms 202 im Allgemeinen. Die Anordnung der Tasten 220 und 222 in einer Ecke der Schnittstelle hilft, eine versehentliche Auswahl zu vermeiden, weil davon ausgegangen wird, dass ein Nutzer selten versehentlich eine der Ecken des Geräts berührt.

In einigen Ausführungsformen kann das Remote-Gerät 200 ein Mobiltelefon, ein Smartphone, ein tragbarer Multimedia-Player, ein PDA oder ein anderes tragbares Computergerät sein, das mehrere verschiedene Funktionen ausführen kann. In diesen Ausführungsformen kann eine Registerkartenleiste 208 nützlich sein, um zwischen anderen Funktionen des Remote-Geräts zu navigieren. Die Registerkartenleiste 208 kann ein strukturierter berührungsempfindlicher Bereich mit hierfür auswählbaren Tasten sein. Zum Beispiel könnte das Remote-Gerät 200 über die Taste 218 angewiesen werden, zum Albenmenü zu wechseln, oder über die Taste 216, zum Künstlermenü zu wechseln, oder über die Taste 212, zu einem Suchbildschirm zu wechseln. Die Taste 210 könnte zusätzliche Optionen anbieten. Die Remote-Taste 214 könnte das Remote-Gerät wieder auf die Remote-Schnittstelle zurücksetzen.

In einigen Ausführungsformen kann einer oder können alle der Bereiche 206, 207, 208 und 209 als Teil der Remote-Schnittstellen fehlen. In einigen anderen Ausführungsformen können die Bereiche 206, 207, 208 und 209 Eingaben in verschiedenen Kontexten ignorieren, um eine versehentliche Auswahl zu vermeiden. So können beispielsweise, wenn das Remote-Gerät im Wesentlichen horizontal gehalten wird, alle individuell auswählbaren Eingaben als nicht auswählbar eingestuft werden und wenn es im Wesentlichen vertikal gehalten wird, zur Auswahl aktiv sein.

In einigen Ausführungsformen ist es zur Vermeidung einer versehentlichen Auswahl erforderlich, dass eine Auswahlhandlung innerhalb des individuell auswählbaren Bereichs beginnt und endet. Um beispielsweise den Menübereich zu aktivieren, muss die Berührung innerhalb des Menübereichs 206 beginnen und enden. Beginnt oder endet eine Berührung außerhalb des Menübereichs, aber im primären berührungsempfindlichen Bereich 204, kann die Eingabe als Eingabe des Typs betrachtet werden, der üblicherweise im primären berührungsempfindlichen Bereich 204 gemacht und erkannt wird.

Wie in FIG. 3 dargestellt, empfängt das Berührungsgerät 200 Berührungsereignisse vom Nutzer während ihrer Eingabe mithilfe eines Responder-Berührungsereignismoduls 250, das diese Berührungsereignisse an einen Berührungsereignis-Handler 252 weiterleitet. Der Berührungsereignis-Handler 252 interpretiert die vom Responder-Berührungsereignismodul 250 empfangenen Berührungsereignisse, um Informationen zum Berührungsereignis zu identifizieren. So kann der Berührungsereignis-Handler z. B. die Pixelposition des Berührungsstarts, die Pixelposition des Berührungsendes und die Berührungsbewegung identifizieren. Außerdem kann er die Dauer des Berührungsereignisses interpretieren. Der Berührungsereignis-Handler 252 kann interpretieren, ob das Berührungsereignis zu einer Menüeingabe, einer Auswahlhandlung, einer Kontextmenüeingabe oder einer Startmenüeingabe geführt hat. Diese Informationen werden zu Paketen formatiert, durch das Touch-Packet‑Verschlüsselungs- und -Formatierungsmodul 254 verschlüsselt und durch den TCP-Client 256 an das ferngesteuerte Gerät 300 geschickt.

Auch wenn in FIG. 3 ein TCP-Client 256 zur Übertragung von Daten von der Fernbedienung 200 zum ferngesteuerten Gerät 300 dargestellt ist, kann ein beliebiges Protokoll verwendet werden, um Daten vom Gerät 200 zum Gerät 300 zu senden. In dieser Ausführungsform wird jedoch wegen seiner Geschwindigkeitsvorteile von TCP ausgegangen. TCP kann so konfiguriert werden, dass es im Wesentlichen unidirektional arbeitet, ohne dass ein Handshake oder eine andere unnötige Kommunikation erforderlich wäre, die die Latenz bei der Übertragung von Daten von der Fernbedienung zum ferngesteuerten Gerät erhöhen kann. Es versteht sich, dass jede Art von Technologie, sei es eine direkte Verbindung von Gerät zu Gerät oder eine über ein lokales Netzwerk, eine relativ schnelle und zuverlässige Übermittlung der vom Berührungsgerät 200 gesendeten Informationen erlauben sollte.

Daneben sollte zum Zwecke einer raschen Übertragung der Befehle vom Berührungsgerät 200 zum ferngesteuerten Gerät 300 die Menge der gesendeten Daten so gering wie möglich gehalten werden. In einigen Ausführungsformen umfasst die übertragene Datenmenge ungefähr 20 bis 50 Bytes pro Paket. Auch wenn die Berührungsschnittstelle des Berührungsgeräts 200 ein vielseitiges Instrument ist, das Daten aufzeichnen und in komplexere Befehle für das Remote-Gerät übertragen kann, so ist Komplexität nicht von Vorteil. Stattdessen werden vom Berührungsgerät 200 einfache Informationen aufgezeichnet und übertragen.

Im Remote-Kontext ist es wichtig, dass die Befehle schnell vom Remote-Gerät 200 übertragen und vom ferngesteuerten Gerät 300 empfangen werden. In der in FIG. 3 dargestellten Ausführungsform sendet deshalb das Remote-Gerät weitgehend generische Berührungsgerätedaten und überlässt die Interpretation der Daten dem ferngesteuerten Gerät 300. So empfängt beispielsweise der TCP-Server 302 die vom TCP-Client 256 übermittelten Daten, und diese werden vom Modul 304 entschlüsselt.

Die generischen Berührungsdaten (Berührungsbeginn, -bewegung, -ende, -zeit/-geschwindigkeit) können von einem Interpreter wie dem Berührungsereignis‑Interpreter 306 interpretiert werden, der die generischen Berührungsereignisdaten in Ereignisse interpretiert, die vom ferngesteuerten Gerät 300 verstanden und verwendet werden können. In diesem Beispiel können die vom Remote-Gerät 200 erfassten Informationen wie Berührungsbeginn, -bewegung und -ende als Ereignisse interpretiert werden: links, rechts, oben, unten, nach links wischen, nach rechts wischen, nach oben wischen, nach unten wischen oder generisch als Berührungsbeginn, -bewegung oder -ende.

Ebenfalls dargestellt ist ein Ereignis-Handler 308, der Eingaben empfangen und an eine Steuerung für eine grafische Benutzerschnittstelle (UI-Controller) weiterleiten kann. Wie dargestellt, kann der Ereignis-Handler 308 Ereignisse von einer Standardfernbedienung 330 empfangen, die vom Human Interface Event Manager 310 empfangen und interpretiert wurden, und er kann auch Ereignisse vom Berührungsgerät 200 empfangen, die vom Berührungsereignis‑Interpreter 306 interpretiert wurden.

Jede grafische Benutzerschnittstelle des ferngesteuerten Geräts wird von einem oder mehreren UI-Controllern gesteuert. Wie in FIG. 3 veranschaulicht, wird der UI-Controller als fokussierter UI-Controller 312 bezeichnet, weil er derjenige UI-Controller ist, der der gerade vom ferngesteuerten Gerät angezeigten GUI zugeordnet ist. Während es viele UI-Controller geben kann, ist der fokussierte UI-Controller derjenige, der dem gerade angezeigten GUI-Bildschirm zugeordnet ist.

Der fokussierte UI-Controller 312 empfängt Ereignisse vom Ereignis-Handler 308. Der fokussierte UI-Controller 312 empfängt alle möglichen Eingaben und reagiert auf jede Eingabe, für deren Annahme der fokussierte UI-Controller konfiguriert ist.

In FIG. 4 bis 6 wird veranschaulicht, wie verschiedene fokussierte UI-Controller mit demselben Satz von Berührungsereignissen umgehen. Bei 340 gibt ein Nutzer eine Geste ein, die an einem beliebigen Punkt X der Berührungsschnittstelle beginnt und am Punkt X-10 links von X endet, wobei die Berührungsgeste eine gewisse Geschwindigkeit hat. Die Berührungseingabe wird wie oben beschrieben empfangen, verarbeitet und an das ferngesteuerte Gerät gesendet. Am ferngesteuerten Gerät empfängt der Berührungsereignis‑Interpreter 346 die Daten, die die Berührungseingabe beschreiben, und kann die Daten in Ereignisse 342 interpretieren, die vom ferngesteuerten Gerät erkannt werden können. In diesem Beispiel gibt der Berührungsereignis‑Interpreter ein Ereignis "nach links wischen" und ein Ereignis "links" aus.

Der Ereignis-Handler 348 leitet das Ereignis "links" und das Ereignis "nach links wischen" an den UI-Controller weiter, der gerade "im Fokus" ist. Ein UI-Controller ist dann "im Fokus", wenn er zumindest einen Teil des gerade angezeigten Bildschirms der Benutzerschnittstelle steuert. Der fokussierte UI-Controller empfängt Ereignisse vom Ereignis-Handler 348. In FIG. 4 bis 6 gibt es drei verschiedene fokussierte UI-Controller. Ein Filmmenü-fokussierter UI-Controller 315, ein Diashow-fokussierter UI-Controller 317 und ein Medienwiedergabe-fokussierter UI-Controller 319. In FIG. 4 empfängt der Filmmenü-fokussierte UI-Controller 315 die Berührungsereignisse 342 vom Ereignis-Handler 348 und erkennt das Ereignis "nach links wischen" bei 344 und veranlasst die UI, scheinbar durch die Auswahl zu scrollen und das Scrollen bei 350 zu beenden. In FIG. 5 ist der Diashow-fokussierte UI-Controller 317 der aktive Controller und erkennt das Ereignis "links" bei 352, was dazu führt, dass die Benutzerschnittstelle bei 354 zur vorangehenden Folie in der Diashow zurückkehrt. In FIG. 6 ist der Medienwiedergabe-fokussierte UI-Controller 319 der aktive Controller und erkennt das Ereignis "nach links wischen" bei 356, was dazu führt, dass die Benutzerschnittstelle bei 358 zur vorangehenden Folie in der Diashow zurückkehrt. In FIG. 4 bis 6 wird dargestellt, wie dieselbe Berührungseingabe als jeweils anderes Ereignis erkannt werden kann und wie die fokussierten UI-Controller eine Auswahl aus den Ereignissen treffen, um eine Aktion in der Benutzerschnittstelle auszulösen.

Auch wenn in den in FIG. 4 bis 6 dargestellten Beispielen die fokussierten UI-Controller nur eines der beiden Eingabeereignisse erkennen, könnte der fokussierte UI-Controller ebenso mehrere Ereignisse als an Aktionen gebunden erkennen. So könnte der Filmmenü-Controller sowohl das Ereignis "Wischen" als auch das Ereignis "links" erkennen, für einen solchen Fall aber so konfiguriert werden, dass er bei Erkennung mehrerer Ereignisse ein Ereignis gegenüber einem anderen priorisiert.

An dieser Stelle ist es sinnvoll zu vergleichen, wie die gerade beschriebene Technologie im Vergleich zu einer Standardfernbedienung 330 gemäß FIG. 3 funktioniert. Die Fernbedienung 200 kann als Universalfernbedienung ausgelegt sein, die unabhängig von dem Gerät, mit dem sie kommuniziert, dieselben Daten ausgeben kann. Es handelt sich um eine Fernbedienung mit unstrukturierter Schnittstelle, sodass beliebige Gesten oder Befehle eingegeben werden können. Im Gegensatz dazu ist die Fernbedienung 330 spezifisch für das ferngesteuerte Gerät ausgelegt. Für die vorliegenden Zwecke wird von einer einfachen Fernbedienung mit nur einer Menütaste, nach oben, nach unten, nach links und nach rechts ausgegangen. Das ferngesteuerte Gerät ist so konfiguriert, dass es Eingaben von der Fernbedienung 330 akzeptiert und jede Eingabe mit einer Funktion im ferngesteuerten Gerät verknüpft ist. Selbst eine herkömmliche Universalfernbedienung ist so programmiert, dass sie genauso wie die Fernbedienung 330 funktioniert und für das ferngesteuerte Gerät spezifische Befehle ausgibt.

Eingaben des Berührungsgeräts 200 werden vom Berührungsereignis‑Interpreter 306 empfangen, der die Berührungsdaten in Berührungsereignisse uminterpretieren kann, die vom Remote-Gerät potenziell verarbeitet werden können. Der Ereignis-Handler 308 leitet die Ereignisse an den fokussierten UI-Controller 312 weiter. Eine Eingabe von der Standardfernbedienung 330 kann vom Human Interface Event Manager 310 empfangen und in ein Ereignis uminterpretiert werden, das vom Berührungsgerät verwendet werden kann. Genau wie bei den vom Berührungsgerät 200 empfangenen Ereignissen kann der Ereignis-Handler 308 den Befehl von der Standardfernbedienung 330 an den fokussierten UI-Controller 312 weiterleiten.

In einigen Ausführungsformen kann der fokussierte UI-Controller 312 so konfiguriert sein, dass er zusätzliche Eingaben über das hinaus akzeptiert, was bei Verwendung der Standardfernbedienung 330 möglich ist. In solchen Ausführungsformen kann der fokussierte UI-Controller 312 unter den Eingaben, die er akzeptieren möchte, auswählen und ist so konfiguriert, dass er diese Auswahl trifft. Beispielsweise kann der fokussierte UI-Controller 312 die Information erhalten, dass er Ereignisse vom Berührungsgerät 200 empfängt, und diese Befehle als höherrangig gegenüber den von der Standardfernbedienung 330 eingehenden einfachen Eingaben wie "links" einstufen. Würde der fokussierte UI-Controller 312 in einem solchen Fall Ereignisse vom Berührungsgerät 200 empfangen, müsste er zwischen dem einfachen Ereignis und dem höherrangigen Ereignis wie einem Wischen wählen, weil beide möglich sind. Der fokussierte UI-Controller 312 kann lernen, dass die Daten vom Berührungsgerät 200 stammen, und kann wählen, auf der Grundlage des Ereignisses "Wischen" einen Film vorzuspulen, anstatt auf der Grundlage des Ereignisses "links" ein Filmkapitel zu überspringen.

So wie der fokussierte UI-Controller 312 konfiguriert werden kann, um verschiedene Befehle zu akzeptieren, je nachdem von welchem Gerät er die Befehle empfängt, kann er die Befehle auch auf der Grundlage des Kontexts der gerade angezeigten Schnittstelle interpretieren. Wie vorstehend erwähnt, ist jeder fokussierte UI-Controller für einen spezifischen Kontext zuständig. Es können viele weitere UI-Controller vorhanden sein, die jeweils für ihre eigene Funktion zuständig sind. Da jeder UI-Controller für einen anderen Teil der Benutzerschnittstelle oder einen anderen Bildschirm mit einem anderen Kontext zuständig ist, kann jeder fokussierte UI-Controller trotz gleicher Eingabe andere Funktionen ausführen.

Wie oben erörtert, kann ein Nutzer verschiedene Eingaben im primären berührungsempfindlichen Bereich 204 vornehmen, doch das Ergebnis der Eingaben kann je nach Kontext der Eingabe variieren. Der fokussierte UI-Controller, der für eine bestimmte GUI spezifisch ist, kann so programmiert werden, dass Eingaben basierend auf Elementen oder Merkmalen seines Kontexts interpretiert werden. Beispielsweise kann es bei der Fernsteuerung einer Multimedia-Anwendung, die auf einem Remote-Gerät läuft, mindestens einen Menükontext (FIG. 7) und einen Medienwiedergabekontext (FIG. 8) geben, die jeweils ihren eigenen fokussierten UI-Controller haben, der ihr Verhalten regelt. Auch wenn die Fernsteuerung einer Multimedia-Anwendung als beispielhafte Ausführungsform erörtert wird, können viele andere Geräte gemäß den hier erörterten Konzepten gesteuert werden, einschließlich, aber nicht beschränkt auf Fernseher, Kabelboxen, digitale Videoaufzeichnungen oder Abspielgeräte von digitalen Disks (DVD, CD, HD-DVD, Blu-Ray usw.).

In Bezug auf das Beispiel einer Multimedia-Anwendung, die auf einem Remote-Gerät ausgeführt wird, bedeutet das: in einem Menükontext kann ein Nutzer Medien potenziell nach Titel, Künstler, Medientyp, Wiedergabelisten, Albumnamen und Genre durchsuchen (natürlich eignen sich einige dieser Kategorien zum Durchsuchen von Medien für bestimmte Medientypen, wie z. B. Filme oder Musiktitel, besser und für andere weniger). In FIG. 7 kann ein Nutzer die Menüschnittstelle nach Filmtiteln durchsuchen, die in einer Liste angeordnet sind. Im Menükontext können im primären berührungsempfindlichen Bereich verschiedene Eingaben vorgenommen werden, um im Menü zu navigieren und eine Auswahl zu treffen. Beispielsweise kann ein Nutzer, wie in der folgenden Tabelle gezeigt, in der Benutzerschnittstelle in eine gewünschte Richtung wischen, was zu einer Bildlaufoperation führen kann. Wie aus dem Stand der Technik bekannt ist, können die Geschwindigkeit der Geste und die Bildlaufoperation in Beziehung gesetzt werden. Beispielsweise kann eine schnellere Wischbewegung zu einer schnelleren Bildlaufoperation und/oder einer längeren Bildlaufdauer führen.

Darüber hinaus kann der primäre berührungsempfindliche Bereich auch Tippgesten empfangen, mit denen ein Element ausgewählt werden kann. Weiter kann das Ziehen eines Fingers des Nutzers über den primären berührungsempfindlichen Bereich 204 ein ausgewähltes oder markiertes Element bewegen.

TABELLE 1

Menü-Navigationskontext |

|

Berührungsaktion |

Ergebnis |

Ziehen in die gewünschte Richtung mit einem Finger |

Auswahl verschieben |

Wischen in die gewünschte Richtung mit einem Finger |

Durch die Auswahl scrollen und zum Ende langsamer werden |

Tippen im Hauptauswahlbereich mit einem Finger |

Menüpunkt wählen |

Viele der gleichen Aktionen können in anderen Kontexten zu anderen Ergebnissen oder Aktionen führen, die auf oder von dem ferngesteuerten Gerät ausgeführt werden. So verursachen, wie in der nachstehenden Tabelle zu sehen ist, einige der oben beschriebenen Aktionen andere Ergebnisse in dem in FIG. 8 dargestellten Kontext der Medienwiedergabe. Durch Tippen mit einem Finger im primären berührungsempfindlichen Bereich kann im Wiedergabekontext - anders als im Menükontext, wo dies zu einer Auswahl führt - eine Mediendatei abgespielt oder angehalten werden. In ähnlicher Weise kann eine Ziehaktion zu einer Shuttle-Transportoperation des Shuttles 367 führen. Wischen nach rechts und links kann zu einem Schnellvorlauf nach rechts bzw. links führen, während im Menükontext dadurch gescrollt wird. Ein Wischen nach oben kann bewirken, dass eine Informationsanzeige 365 verschiedene Informationen durchläuft, die sich in einem Media Player möglicherweise anzeigen lassen. Ein Wischen nach unten kann ein Kapitelauswahlmenü anzeigen.

TABELLE 2

Medienwiedergabekontext |

|

Berührungsaktion |

Ergebnis |

Tippen im Auswahlbereich mit einem Finger |

Umschalten Wiedergabe/Pause |

Ziehen nach links/rechts mit einem Finger |

Shuttle-Transport nach links/rechts |

Nach links wischen mit einem Finger |

10 Sekunden zurückspringen |

Nach rechts wischen mit einem Finger |

10 Sekunden vorwärtsspringen |

Nach oben wischen mit einem Finger |

Anzeige der Zyklusinformationen |

Nach unten wischen mit einem Finger |

Kapitelauswahlmenü anzeigen |

Andere Eingaben müssen nicht kontextabhängig sein. So führt ein Tippen im Menübereich 206 zum vorherigen Menübildschirm zurück. Ein Gedrückthalten im Menübereich bewirkt die Rückkehr zum Hauptmenü. Auch einige Eingaben im primären berührungsempfindlichen Bereich 204 führen immer zu der gleichen Aktion - ein Drücken und Gedrückthalten mit zwei Fingern im primären berührungsempfindlichen Bereich 204 führt zum Menü für den vom Gerät gerade angezeigten Kontext zurück.

TABELLE 3

Beliebiger Kontext |

|

Berührungsaktion |

Ergebnis |

Tippen im Menübereich mit einem Finger |

Menü |

Drücken und Gedrückthalten im Menübereich mit einem Finger |

Hauptmenü |

Drücken und Gedrückthalten mit zwei Fingern im Hauptauswahlbereich |

Kontextmenü |

Zusätzlich zu den verschiedenen oben beschriebenen Berührungseingaben sind noch viele weitere Eingaben möglich. Nichts in der bisherigen Beschreibung sollte als Einschränkung der verfügbaren Berührungseingaben oder Gesten verstanden werden, die mit der beschriebenen Technologie verwendet werden können. Beispielsweise werden zusätzlich zu den oben beschriebenen Ein- oder Zwei-Finger-Eingaben auch Drei- oder Vier-Finger-Eingaben in Betracht gezogen. Darüber hinaus können auch komplexere Gesten wie das Spreizen von zwei oder mehr Fingern und die Zuordnung bestimmter Eingaben zu einzelnen Fingern nützlich sein. Derartige Gesten sind im Stand der Technik bereits bekannt, so das Drehen eines Fingers um den anderen, um ein Bildschirmbild zu drehen, oder das Bewegen von zwei Fingern voneinander weg oder aufeinander zu, was zu einem Heraus- oder Hineinzoomen führen kann. Viele andere werden im Rahmen des Fachwissens berücksichtigt.

Auch soll der Begriff Finger, auf den oben und in der gesamten Beschreibung Bezug genommen wird, nicht einschränkend sein. Während sich in einigen Ausführungsformen die Angabe "ein Finger" auf den Finger einer menschlichen Hand bezieht, kann sie sich in anderen Ausführungsformen auf alles beziehen, was von einer kapazitiven Vorrichtung erfasst werden kann. In einigen Ausführungsformen kann sie sich auch auf einen Stift oder ein anderes Objekt zur Eingabe in eine Anzeige-Eingabevorrichtung beziehen.

Nachdem der fokussierte UI-Controller eine Eingabe akzeptiert hat, wirkt sich dies auf die Benutzerschnittstelle des ferngesteuerten Geräts aus. In vielen Fällen kann dies die erste Rückmeldung an den Nutzer sein, dass er den richtigen Befehl erteilt hat. Eine solche Rückkopplungsschleife erhöht die Reaktionsbereitschaft des Systems und ermöglicht eine weniger komplizierte Remote-Schnittstelle. In anderen Ausführungsformen können aber auch andere Arten von Rückmeldungen geliefert werden. Beispielsweise kann der Nutzer eine akustische Rückmeldung erhalten, damit er zumindest weiß, dass ein Befehl erteilt wurde. Alternativ kann die Fernbedienung vibrieren oder jede andere gewünschte Art von Rückmeldung liefern. Die Rückmeldung kann auch befehlsspezifisch sein, ein anderes Geräusch oder eine andere Vibration je nach Befehl ist denkbar.

In einigen Ausführungsformen verfügt das ferngesteuerte Gerät möglicherweise nicht über einen Ereignis‑Interpreter. In diesen Ausführungsformen würde die Fernbedienung die Daten, die Berührungseingaben darstellen, an das ferngesteuerte Gerät senden, und der fokussierte UI-Controller kann konfiguriert werden, um die Daten zu interpretieren.

In einigen Ausführungsformen kann es nützlich sein, der Fernbedienung zu ermöglichen, Informationen zum Ändern von Menüs oder Anzeigen des Remote-Geräts zu erhalten. In solchen Ausführungsformen kann ein separater Kommunikationskanal geöffnet werden, beispielsweise unter Verwendung eines Hypertext-Übertragungsprotokolls (HTTP) zum Übertragen von Informationen zwischen den Geräten. Um die Remote-Leistung aufrechtzuerhalten, könnte die Kommunikation überwiegend nur in eine Richtung ablaufen, um eine schnellere Geschwindigkeit zu erzielen, und nur bei Bedarf eine bidirektionale Kommunikation verwendet werden. Obwohl der Großteil der Kommunikation von der Fernbedienung zum ferngesteuerten Gerät über TCP übertragen wird, könnte beispielsweise HTTP oder DAAP verwendet werden, um die Fernbedienung über Sonderfälle zu informieren, z. B. wenn zusätzliche Informationen verfügbar sind oder auf dem ferngesteuerten Gerät eine Tastatur angezeigt wird. In solchen Fällen könnte beispielsweise auf der Fernbedienung eine Tastatur angezeigt werden, und die Tastatureingaben könnten mittels HTTP übertragen werden. Ähnlich kann, wenn Informationen wie die in FIG. 8 dargestellten verfügbar sind, auf der Fernbedienung eine Informationstaste angezeigt werden, um das Informationsfenster 365 aufzurufen.

FIG. 9 zeigt das Verfahren zum Steuern des Remote-Geräts. In Schritt 418 stellt eine Remote-Anwendung einen unstrukturierten berührungsempfindlichen Bereich zum Empfangen von Berührungseingaben von einem Nutzer bereit. Die Berührungseingaben werden in Schritt 422 empfangen und mindestens in Berührungsstart-, Berührungsende-, Bewegungs- und Dauerdaten uminterpretiert. In Schritt 424 werden die Daten formatiert und an das ferngesteuerte Gerät gesendet.

In Schritt 426 interpretiert das ferngesteuerte Gerät die empfangenen Daten in Kenntnis des Kontexts des gerade von ihm angezeigten Bildschirms. Abhängig von den empfangenen Eingaben und dem Kontext der aktuellen Anzeige interpretiert das ferngesteuerte Gerät die von der Fernbedienung empfangenen Daten und akzeptiert den Befehl in Schritt 428, wodurch es den Befehl ausführt und das Ergebnis in Schritt 430 anzeigt.

Auch wenn in der obigen Beschreibung ein Medienwiedergabegerät mit zugehöriger Software verwendet wird, versteht es sich, dass die Technologie gleichermaßen auf andere ferngesteuerte Geräte wie Fernseher, DVR, DVD-Player, Blu-ray, Kabelboxen usw. anwendbar ist. Das ferngesteuerte Gerät kann beispielsweise so programmiert werden, dass es generische Touchscreen-Schnittstellendaten akzeptiert, interpretiert und auf diese Eingaben reagiert. Alternativ kann die Fernbedienung selbst mit Anweisungen ausgestattet werden, wie sie mit nahezu jedem ferngesteuerten Gerät kommunizieren kann. Solange entweder das Remote-Gerät oder das ferngesteuerte Gerät die Berührungsdaten basierend auf dem Kontext dessen interpretieren kann, was aktuell angezeigt wird oder vom Remote-Gerät angezeigt werden soll, können die Prinzipien der beschriebenen Technologie angewendet werden.

In einigen Ausführungsformen sind weniger oder stärker berührungsempfindliche Bereiche möglich. Zusätzliche berührungsempfindliche Bereiche mit strukturierten Schnittstellen erhöhen jedoch die Wahrscheinlichkeit, dass versehentlich Befehle in die Fernbedienung eingegeben werden. Die besten Benutzerschnittstellen bieten insgesamt ein Nutzererlebnis, bei dem der Nutzer selten auf die Fernbedienung schauen muss, um eine Auswahl zu treffen. Wenn der Nutzer in einer Berührungsumgebung, in der sich das gesamte Gerät für den Nutzer ähnlich anfühlt, nicht auf die Fernbedienung schaut, versteht es sich jedoch, dass versehentliche Eingaben möglich und sogar wahrscheinlich sind, wenn zu viele individuell auswählbare Elemente verfügbar sind.

Es gibt verschiedene Methoden, um versehentliche Eingaben zu vermeiden. Eine davon verwendet, wie oben beschrieben, ein Beschleunigungsmessgerät, um die Geräteorientierung zu bestimmen und basierend auf dieser Orientierung festzustellen, welche Art von Befehl der Nutzer einzugeben versucht. Wenn das Gerät waagerecht gehalten wird, schaut der Nutzer wahrscheinlich nicht auf das Gerät, und es ist wahrscheinlich, dass das ferngesteuerte Gerät mit Gesten gesteuert werden soll. Wenn das Gerät jedoch eher vertikal oder schräg gehalten wird, damit der Nutzer den Bildschirm sehen kann, schaut sich der Nutzer wahrscheinlich den Bildschirm an, und Eingaben über die Tasten der strukturierten Benutzerschnittstelle sind wahrscheinlicher. Eine weitere Alternative ist in FIG. 5 dargestellt, wobei das Remote-Gerät 500 in einer Querformatorientierung gedreht wird. In dieser Ausrichtung ist die gesamte Schnittstelle unstrukturiert, und nur der primäre Auswahlbereich 502 und der Menüauswahlbereich 504 sind vorhanden. In dieser Ausführungsform würden versehentliche Eingaben vermieden, indem der strukturierte Teil der Schnittstelle verschwindet, wenn der Nutzer nur die unstrukturierte Schnittstelle verwenden möchte, um Berührungsgesten zur Steuerung des ferngesteuerten Geräts einzugeben. Wenn das Gerät in das Hochformat gedreht wird, kann eine strukturierte Schnittstelle verfügbar werden. Eine weitere Möglichkeit, unerwünschte Eingaben zu reduzieren, besteht darin, den Anzeigebereich des Touchscreens unabhängig von der Ausrichtung des Geräts vollständig auszuschalten. In diesen Ausführungsformen wäre nur eine unstrukturierte Eingabe in den primären Auswahlbereich und den Menübereich verfügbar. Würde der Nutzer eine der strukturierten Optionen wünschen, könnte der Bildschirm durch einen Betätigungsmechanismus wie eine Hardwaretaste, ein Schütteln des Geräts oder eine Berührungsgeste wieder eingeschaltet werden.

Außerdem können, wie oben beschrieben, versehentliche Eingaben vermieden werden, indem die Berührungsschnittstelle so konfiguriert wird, dass jede Eingabe, die sich in eine strukturierte Eingabe hinein oder aus einer solchen heraus bewegt, als Eingabe in die unstrukturierte Schnittstelle akzeptiert wird. Auf diese Weise werden nur absichtliche Auswahlhandlungen registriert.

Unter den Schutzumfang der vorliegenden Erfindung fallende Ausführungsformen können auch computerlesbare Medien als Träger oder Speicherort für computerausführbare Anweisungen oder Datenstrukturen sein. Solche computerlesbaren Medien können alle verfügbaren Medien sein, auf die von einem Universal- oder Spezialcomputer zugegriffen werden kann. Beispielhaft und nicht einschränkend können solche physischen computerlesbaren Medien RAM, ROM, EEPROM, CD-ROM oder einen anderen optischen Plattenspeicher, einen Magnetplattenspeicher oder andere magnetische Speichervorrichtungen oder ein beliebiges anderes Medium umfassen, das verwendet werden kann, um gewünschte Programmcodemittel in Form von computerausführbaren Anweisungen oder Datenstrukturen zu tragen oder zu speichern. Wenn Informationen über ein Netzwerk oder eine andere Kommunikationsverbindung (entweder fest verdrahtet, drahtlos oder eine Kombination davon) an einen Computer übertragen oder für diesen bereitgestellt werden, betrachtet der Computer die Verbindung korrekterweise als computerlesbares Medium. Daher wird jede solche Verbindung korrekterweise als computerlesbares Medium bezeichnet. Kombinationen der oben genannten Medien sollten also auch unter die physischen computerlesbaren Medien fallen.

Computerausführbare Anweisungen umfassen beispielsweise Anweisungen und Daten, die bewirken, dass ein Universalcomputer, ein Spezialcomputer oder eine Spezialverarbeitungsvorrichtung eine bestimmte Funktion oder Gruppe von Funktionen ausführt. Computerausführbare Anweisungen umfassen auch Programmmodule, die von Computern in eigenständigen oder in Netzwerkumgebungen ausgeführt werden. Im Allgemeinen umfassen Programmmodule Routinen, Programme, Objekte, Komponenten und Datenstrukturen, die bestimmte Aufgaben ausführen oder bestimmte abstrakte Datentypen implementieren. Computerausführbare Anweisungen, zugehörige Datenstrukturen und Programmmodule stellen Beispiele der Programmcodemittel zum Ausführen von Schritten der hier offenbarten Verfahren dar. Die bestimmte Abfolge solcher ausführbarer Anweisungen oder der zugehörigen Datenstrukturen steht beispielhaft für entsprechende Handlungen zur Implementierung der in solchen Schritten beschriebenen Funktionen.

Fachleute werden erkennen, dass weitere Ausführungsformen der Erfindung in Netzwerkcomputerumgebungen mit vielen Arten von Computersystemkonfigurationen ausgeführt werden können, darunter Personal Computer, tragbare Geräte, Multiprozessorsysteme, mikroprozessorbasierte oder programmierbare Unterhaltungselektronik, Netzwerk-PCs, Minicomputer, Großrechner und dergleichen. Ausführungsformen können auch in verteilten Computerumgebungen implementiert werden, in denen Aufgaben von lokalen und entfernten Verarbeitungsgeräten ausgeführt werden, die über ein Kommunikationsnetzwerk (entweder durch festverdrahtete Verbindungen, drahtlose Verbindungen oder durch eine Kombination davon) verbunden sind. In einer verteilten Computerumgebung können sich Programmmodule sowohl in lokalen als auch in entfernten Speichervorrichtungen befinden.

Die Kommunikation in verschiedenen Stufen des beschriebenen Systems kann über ein lokales Netzwerk, ein Token-Ring-Netzwerk, das Internet, ein Unternehmens‑Intranet, drahtlose Signale der 802.11-Serie, ein Glasfasernetz, eine Funk- oder Mikrowellenübertragung usw. erfolgen. Die zugrunde liegende Technologie kann sich zwar ändern, aber die hier beschriebenen Grundprinzipien sind weiterhin anwendbar.

Die verschiedenen oben beschriebenen Ausführungsformen dienen nur der Veranschaulichung und sollen die Erfindung nicht einschränken. Zum Beispiel können die hier dargestellten Prinzipien auf jedes ferngesteuerte Gerät angewendet werden. Ferner wird der Fachmann erkennen, dass die Kommunikation zwischen der Fernbedienung und dem ferngesteuerten Gerät nicht auf die Kommunikation über ein lokales Netzwerk beschränkt sein muss, sondern auch die Kommunikation über Infrarotkanäle, Bluetooth oder eine andere geeignete Kommunikationsschnittstelle umfassen kann. Fachleute werden ohne Weiteres verschiedene Modifikationen und Änderungen erkennen, die an der vorliegenden Erfindung vorgenommen werden können, ohne den hier veranschaulichten und beschriebenen beispielhaften Ausführungsformen und Anwendungen zu folgen und ohne vom Umfang der vorliegenden Offenbarung abzuweichen.

1. Verfahren zur Fernsteuerung eines Geräts (300), umfassend:

R. 43 (1) a)

Oberbegriff des unabhängigen Anspruchs, soweit angebracht

Empfangen von Berührungseingabedaten an einem ferngesteuerten Gerät (300) von einer Fernbedienung (200) umfassend einen Touchscreen (202) und eine Prozessoreinheit, wobei die Berührungseingabedaten Informationen einschließlich Positions-, Bewegungs- und Dauer-Eingabeparameter umfassen und wobei die Berührungseingabedaten vom ferngesteuerten Gerät (300) interpretiert werden können als ein Befehl aus einer Vielzahl möglicher Befehle in einem ersten Kontext einer grafischen Benutzerschnittstelle (Graphical User Interface, GUI) des ferngesteuerten Geräts (300) und als ein anderer Befehl aus der Vielzahl möglicher Befehle in einem zweiten Kontext der GUI, Interpretieren der Berührungseingabedaten in Kombination mit einem aktuellen Kontext der GUI, um einen für den aktuellen Kontext der GUI passenden Befehl zu bestimmen; und

Aktualisieren der GUI als Reaktion auf den passenden Befehl, dadurch gekennzeichnet, dass das Verfahren außerdem das Senden von Informationen vom ferngesteuerten Gerät (300) über ein bidirektionales Kommunikationsprotokoll zur Fernbedienung (200) umfasst, womit die Fernbedienung informiert wird, zumindest teilweise als Reaktion auf die über das bidirektionale Kommunikationsprotokoll empfangenen Informationen eine Tastatur auf dem Touchscreen anzuzeigen.

2. System umfassend:

eine Fernbedienung (200) umfassend:

einen Touchscreen (202), der zum Empfangen von Berührungseingaben konfiguriert ist,

eine Prozessoreinheit zum Empfangen der elektronischen Signale vom Touchscreen und Übersetzung der Signale in Berührungseingabedaten und

eine Kommunikationsschnittstelle, die konfiguriert ist zum:

Senden der Berührungseingabedaten an ein ferngesteuertes Gerät (300), wobei die Daten zumindest Positions-, Bewegungs- und Dauer-Eingabeparameter einschließen, und

Empfangen von Informationen vom ferngesteuerten Gerät (300) über ein bidirektionales Kommunikationsprotokoll, mit denen die Fernbedienung informiert wird, eine Tastatur anzuzeigen, wobei die Fernbedienung so konfiguriert ist, dass sie zumindest teilweise als Reaktion auf die über das bidirektionale Kommunikationsprotokoll empfangenen Informationen eine Tastatur auf dem Touchscreen anzeigt,

ein ferngesteuertes Gerät (300), das konfiguriert ist, eine grafische Benutzerschnittstelle (GUI) in einer Vielzahl von Kontexten zu präsentieren,

wobei das ferngesteuerte Gerät umfasst:

ein Display zur Anzeige einer grafischen Benutzerschnittstelle (GUI),

eine Kommunikationsschnittstelle, die konfiguriert ist zum:

Empfangen der Berührungseingabedaten, wobei die Berührungseingabedaten vom ferngesteuerten Gerät (300) interpretiert werden können als ein Befehl aus einer Vielzahl möglicher Befehle in einem ersten Kontext einer grafischen Benutzerschnittstelle (GUI) des ferngesteuerten Geräts (300) und als ein anderer Befehl aus der Vielzahl möglicher Befehle in einem zweiten Kontext der GUI, und

eine Prozessoreinheit, die konfiguriert ist, um die Berührungseingabedaten in Kombination mit einem aktuellen Kontext der GUI zu interpretieren, um einen für den aktuellen Kontext passenden Befehl zu bestimmen und um die GUI in Reaktion auf den passenden Befehl zu aktualisieren,

dadurch gekennzeichnet, dass

die Kommunikationsschnittstelle außerdem konfiguriert ist zum:

Senden von Informationen über ein bidirektionales Kommunikationsprotokoll, womit die Fernbedienung informiert wird, zumindest teilweise als Reaktion auf die über das bidirektionale Kommunikationsprotokoll empfangenen Informationen eine Tastatur auf dem Touchscreen anzuzeigen.

3. Gerät, konfiguriert über eine Anwendung, die das Gerät veranlasst, als Fernbedienung (200) für ein ferngesteuertes Gerät zu funktionieren, umfassend:

einen Touchscreen (202), der zum Empfangen von Berührungseingaben konfiguriert ist,

eine Prozessoreinheit, um die elektronischen Signale vom Touchscreen zu empfangen und die Signale in Berührungseingabedaten zu übersetzen, und

eine Kommunikationsschnittstelle, die konfiguriert ist zum:

Senden der Berührungseingabedaten zu einem ferngesteuerten Gerät (300), wobei die Daten zumindest Positions-, Bewegungs- und Dauer-Eingabeparameter einschließen und wobei die Berührungseingabedaten vom ferngesteuerten Gerät (300) interpretiert werden können als ein Befehl aus einer Vielzahl möglicher Befehle in einem ersten Kontext einer grafischen Benutzerschnittstelle (GUI) des ferngesteuerten Geräts (300) und als ein anderer Befehl aus der Vielzahl möglicher Befehle in einem zweiten Kontext der GUI,

wobei das ferngesteuerte Gerät konfiguriert ist, um die Berührungseingabedaten in Kombination mit einem aktuellen Kontext der GUI zu interpretieren, um einen für den aktuellen Kontext passenden Befehl zu bestimmen und um die GUI in Reaktion auf den passenden Befehl zu aktualisieren,

dadurch gekennzeichnet, dass

die Kommunikationsschnittstelle außerdem konfiguriert ist zum:

Empfangen von Informationen vom ferngesteuerten Gerät (300) über ein bidirektionales Kommunikationsprotokoll, womit die Fernbedienung informiert wird, zumindest teilweise in Reaktion auf die über das bidirektionale Kommunikationsprotokoll empfangenen Informationen eine Tastatur auf dem Touchscreen anzuzeigen.

4. Gerät, konfiguriert über eine Anwendung, die das Gerät dazu veranlasst, als ferngesteuertes Gerät (300) zu funktionieren, das von einer Fernbedienung (200) gesteuert wird, umfassend:

ein Display zur Anzeige einer grafischen Benutzerschnittstelle (GUI),

eine Kommunikationsschnittstelle, die konfiguriert ist zum:

Empfangen von Berührungseingabedaten von einer Fernbedienung (200), wobei die Daten zumindest Positions-, Bewegungs- und Dauer-Eingabeparameter einschließen und wobei die Berührungseingabedaten vom ferngesteuerten Gerät (300) interpretiert werden können als ein Befehl aus einer Vielzahl möglicher Befehle in einem ersten Kontext einer grafischen Benutzerschnittstelle (GUI) des ferngesteuerten Geräts (300) und als ein anderer Befehl aus der Vielzahl möglicher Befehle in einem zweiten Kontext der GUI, und

eine Prozessoreinheit, die konfiguriert ist, um die Berührungseingabedaten in Kombination mit einem aktuellen Kontext der GUI zu interpretieren, um einen für den aktuellen Kontext passenden Befehl zu bestimmen und um die GUI in Reaktion auf den passenden Befehl zu aktualisieren,

dadurch gekennzeichnet, dass

die Kommunikationsschnittstelle außerdem konfiguriert ist zum:

Senden von Informationen über ein bidirektionales Kommunikationsprotokoll, womit die Fernbedienung informiert wird, zumindest teilweise in Reaktion auf die über das bidirektionale Kommunikationsprotokoll empfangenen Informationen eine Tastatur auf dem Touchscreen anzuzeigen.

5. Computerprogrammprodukt, umfassend Befehle, die bei der Ausführung des Programms durch das System nach Anspruch 2 dieses veranlassen, das Verfahren nach Anspruch 1 auszuführen.

6. Computerprogrammprodukt, umfassend Befehle, die bei der Ausführung des Programms durch ein Computergerät mit einem Touchscreen, einer Prozessoreinheit zum Empfangen elektronischer Signale vom Touchscreen und einer Kommunikationsschnittstelle

bewirken, dass das Computergerät als Fernbedienung (200) für ein ferngesteuertes Gerät funktioniert,

wobei die Befehle bewirken, dass das Computergerät:

das Berührungseingabesignal vom Touchscreen in Berührungseingabedaten übersetzt,

die Berührungseingabedaten an ein ferngesteuertes Gerät (300) sendet, wobei die Daten zumindest Positions-, Bewegungs- und Dauer-Eingabeparameter einschließen und wobei die Berührungseingabedaten vom ferngesteuerten Gerät (300) interpretiert werden können als ein Befehl aus einer Vielzahl möglicher Befehle in einem ersten Kontext einer grafischen Benutzerschnittstelle (GUI) des ferngesteuerten Geräts (300) und als ein anderer Befehl aus der Vielzahl möglicher Befehle in einem zweiten Kontext der GUI,

wobei das ferngesteuerte Gerät konfiguriert ist, um die Berührungseingabedaten in Kombination mit einem aktuellen Kontext der GUI zu interpretieren, um einen für den aktuellen Kontext passenden Befehl zu bestimmen und um die GUI in Reaktion auf den passenden Befehl zu aktualisieren,

dadurch gekennzeichnet, dass die Befehle ferner bewirken, dass das Computergerät:

Informationen vom ferngesteuerten Gerät (300) über ein bidirektionales Kommunikationsprotokoll empfängt, womit die Fernbedienung informiert wird, zumindest teilweise in Reaktion auf die über das bidirektionale Kommunikationsprotokoll empfangenen Informationen eine Tastatur auf dem Touchscreen anzuzeigen.

7. Computerprogrammprodukt, umfassend Befehle, die bei der Ausführung des Programms durch ein Computergerät mit einem Display, einer Prozessoreinheit und einer Kommunikationsschnittstelle

bewirken, dass das Gerät als ferngesteuertes Gerät (300) funktioniert, das von einer Fernbedienung (200) gesteuert wird,

wobei die Befehle bewirken, dass das Computergerät:

eine grafische Benutzerschnittstelle (GUI) anzeigt,

Berührungseingabedaten von einer Fernbedienung (200) empfängt, wobei die Daten zumindest Positions-, Bewegungs- und Dauer-Eingabeparameter einschließen und wobei die Berührungseingabedaten vom ferngesteuerten Gerät (300) interpretiert werden können als ein Befehl aus einer Vielzahl möglicher Befehle in einem ersten Kontext einer grafischen Benutzerschnittstelle (GUI) des ferngesteuerten Geräts (300) und als ein anderer Befehl aus der Vielzahl möglicher Befehle in einem zweiten Kontext der GUI,

die Berührungseingabedaten in Kombination mit einem aktuellen Kontext der GUI interpretiert, um einen für den aktuellen Kontext passenden Befehl zu bestimmen und um die GUI in Reaktion auf den passenden Befehl zu aktualisieren,

dadurch gekennzeichnet, dass die Befehle ferner bewirken, dass das Computergerät:

Informationen über ein bidirektionales Kommunikationsprotokoll sendet, womit die Fernbedienung informiert wird, zumindest teilweise in Reaktion auf die über das bidirektionale Kommunikationsprotokoll empfangenen Informationen eine Tastatur auf dem Touchscreen anzuzeigen.

Zusammenfassung

Richtungs-Berührungs-Fernbedienung

R. 47 (1)

Erfindungsbezeichnung

Das vorliegende System und das vorliegende Verfahren sind besonders nützlich für die Fernsteuerung eines Geräts mit einem oder mehreren Menüs über eine Fernberührungsschnittstelle, die mindestens einen unstrukturierten primären Eingabebereich aufweist. Ein Nutzer kann über eine Berührungsschnittstelle Eingaben vornehmen, ohne die Schnittstelle ansehen zu müssen, und dennoch die erwünschte Reaktion des ferngesteuerten Geräts erzielen. Der primäre Eingabebereich der Berührungsschnittstelle kann eine Hintergrundanzeige wie bei einem Touchscreen aufweisen oder nicht; der primäre Eingabebereich der Berührungsschnittstelle sollte jedoch unstrukturiert sein und sollte keine unabhängig auswählbaren Elemente, Tasten, Symbole oder Ähnliches aufweisen. Da die Berührungsschnittstelle unstrukturiert ist, muss der Nutzer keine auswählbaren Tasten identifizieren. Stattdessen kann er eine Geste in die Schnittstelle eingeben und beobachten, wie das ferngesteuerte Gerät reagiert. Das System liefert keine andere visuelle Bestätigung.