Annexe II – Exemples de demandes de brevet européen

|

Le texte révisé de cette publication est entré en vigueur. |

Télécommande tactile directionnelle

Titre de l'invention (l'indication dans la requête en délivrance suffit)

La présente technologie concerne des télécommandes et plus particulièrement des télécommandes tactiles.

R. 42(1)a)

Domaine technique auquel se rapporte l'invention

INTRODUCTION

Les dispositifs devenant plus complexes, les télécommandes qui les contrôlent suivent la même évolution. Les premières télécommandes étaient efficaces de par leur simplicité mais au fur et à mesure de l'évolution des technologies, elles ont perdu de leur facilité de fonctionnement. Aujourd'hui, il est courant de trouver des versions évoluées de télécommandes comportant cinquante boutons, chacun ayant plusieurs fonctions. Ces télécommandes nécessitent souvent d'étudier de près la fonction d'un bouton et elles comportent fréquemment des boutons si petits qu'ils conduisent trop souvent à des commandes non intentionnelles.

Les boutons sont commodes parce qu'ils fournissent un retour tactile de l'introduction d'une commande et, dans certains cas, une sélection de quelques boutons peut même générer un ressenti différent ou une forme différente, ce qui permet d'utiliser plus facilement la télécommande avec une confirmation visuelle minimale indiquant que c'est le bon bouton qui est sélectionné. Même avec des formes ou textures, l'attention de l'utilisateur est trop souvent détournée du dispositif commandé à distance et fixée sur la télécommande – conséquence non souhaitable d'une interface compliquée.

Les télécommandes à écran tactile tentent de résoudre certains de ces problèmes mais peuvent en créer d'autres. Tandis que les télécommandes à écran tactile sont en mesure d'afficher moins d'options à l'écran en même temps en permettant à l'utilisateur de naviguer dans des menus pour trouver la bonne commande, les écrans tactiles ont toujours exigé de l'utilisateur qu'il regarde la télécommande. Les écrans tactiles ne comportent pas de retour tactile, permettant à l'utilisateur de confirmer sa sélection, si bien que l'utilisateur doit confirmer visuellement sa sélection, ce qui n'est pas souhaitable.

R. 42(1)b)

Indication de l'état de la technique

D'autres télécommandes à écran tactile sont spécifiques à l'application et exigent une communication bidirectionnelle, dans laquelle le dispositif commandé à distance donne l'ordre à la télécommande d'afficher une certaine interface graphique utilisateur. L'utilisateur doit regarder la télécommande pour procéder aux sélections parce que l'interface du contrôleur change en fonction du contexte de l'affichage du dispositif commandé à distance. Par ailleurs, ces télécommandes ont comme inconvénient le fait qu'elles peuvent parfois fonctionner trop lentement pour une application à distance, en raison des allers et retours entre la télécommande et le dispositif commandé à distance.

D'autres télécommandes à écran tactile encore commandent un curseur qui s'affiche sur le dispositif commandé à distance. Si ces télécommandes peuvent fonctionner pendant que l'utilisateur regarde le dispositif commandé à distance au lieu de la télécommande en elle-même, elles peuvent exiger toutefois trop d'efforts de l'utilisateur pour saisir une commande. L'utilisateur doit passer par des manipulations contraignantes qui consistent à naviguer avec un curseur dans un menu pour sélectionner la commande. Ce type d'interaction a été supprimé du fait des avantages liés à la commande par simple clic des télécommandes précédentes.

De ce fait, il est souhaitable de disposer d'une télécommande simple, capable de fonctionner sans que l'utilisateur ne regarde l'écran de la télécommande et qui fonctionne rapidement et efficacement tout en minimisant les commandes non intentionnelles.

R. 42(1)c)

Problème technique à résoudre

US2008/0284726 décrit un appareil destiné au contrôle de médias basé sur des capteurs, comprenant un dispositif de média ayant un élément de contrôle pour recevoir d'un contrôleur de médias une première instruction lui demandant de sélectionner un objet conformément au traitement physique du contrôleur de médias, et une seconde instruction lui demandant de commander l'objet identifié ou de réaliser une recherche sur l'objet conformément aux mouvements des doigts sans contact.

US2008/0059578 concerne un système électronique de communication déclenché par des gestes, qui informe des utilisateurs des gestes exécutés par d'autres utilisateurs participant à une session de communication. Le système capture le mouvement à trois dimensions d'un premier utilisateur parmi plusieurs utilisateurs participant à une session de communication électronique, le mouvement à trois dimensions étant déterminé à l'aide d'au moins un dispositif de capture d'image tourné vers le premier utilisateur. Le système identifie le flux de propriétés de l'objet à trois dimensions, utilisant le mouvement capturé, puis il identifie un geste particulier de communication électronique représentant le flux de propriétés de l'objet à trois dimensions, en comparant le flux identifié de propriétés de l'objet à trois dimensions à plusieurs définitions du geste de communication électronique.

US2007/0152976 expose un procédé permettant de rejeter un contact involontaire avec la paume de la main. Dans quelques modes de réalisation au moins, un contact est détecté par une surface sensible, associée à un affichage. Les caractéristiques du contact peuvent être utilisées pour générer un ensemble de paramètres liés au contact. Dans un mode de réalisation, un micrologiciel est utilisé pour déterminer une valeur de fiabilité pour le contact. La valeur de fiabilité et l'endroit où a eu lieu le contact sont communiqués à un module logiciel. Ce dernier utilise la valeur de fiabilité et un contexte d'activité pour déterminer le niveau de confiance du contact. Dans un mode de réalisation, le niveau de confiance peut inclure une évaluation des variations de la valeur de fiabilité au cours du temps. Si le niveau de confiance du contact est trop faible, il peut être rejeté.

US2004/0218104 concerne une interface utilisateur destinée à des centres multimédias, laquelle utilise des dispositifs portables à capteurs inertiels de saisie par l'utilisateur, pour sélectionner les canaux et naviguer rapidement dans des menus denses d'options. L'utilisation très poussée de la haute résolution et de la bande passante de ces dispositifs de saisie par l'utilisateur est combinée à des stratégies visant à éviter les saisies non intentionnelles et à des affichages graphiques interactifs denses et intuitifs.

RÉSUMÉ

La présente invention est définie par les revendications indépendantes ci-jointes. D'autres caractéristiques et avantages découlant des concepts divulgués ici sont exposés dans la description qui suit. Ils se dégagent en partie de manière évidente de la description ou pourront être acquis par la pratique des technologies décrites. Les caractéristiques et avantages de ces concepts peuvent être réalisés et obtenus au moyen des instruments et combinaisons signalés en particulier dans les revendications ci-jointes. Ces caractéristiques et d'autres caractéristiques des technologies décrites transparaîtront plus largement au travers de la description suivante et des revendications ci-jointes, ou pourront être déduites de la pratique des concepts exposés ici.

R. 42(1)c)

Exposé de l'invention

Le présent exposé décrit les procédés et configurations visant à commander à distance un dispositif à partir des données génériques d'un écran tactile, en affichant une interface graphique utilisateur (GUI) composée d'une multitude de contextes sur un dispositif d'affichage pour contrôler au moins quelques fonctions d'un dispositif. Les données caractérisant un événement tactile peuvent être reçues et interprétées ou traduites en une liste de commandes disponibles. Ces commandes peuvent donner lieu à une action de la part du dispositif, en réponse aux données tactiles telles qu'elles sont interprétées au vu du contexte de la GUI.

Le présent exposé comprend par ailleurs un support lisible par machine pour stocker le code de programme ayant pour effet que le dispositif réalise au moins les étapes du procédé expliqué ci-dessus, ceci tout au long de cette description.

Dans certains cas, le même événement tactile peut affecter la même action dans plusieurs contextes de la GUI mais, dans d'autres cas, le même événement tactile peut affecter différentes actions dans différents contextes de l'interface.

Tout dispositif électronique portable peut servir de télécommande : téléphone mobile, smartphone, PDA ou lecteur média portable.

De même, la télécommande peut commander un nombre quelconque de dispositifs, y compris un programme de gestion multimédia et un lecteur ou un enregistreur vidéo numérique ou un dispositif de réglage de la télévision tel qu'un téléviseur ou un boîtier de connexion par câble.

Est également exposé un dispositif à fonctions multiples utilisant une application lui permettant de servir de télécommande. Il s'agit d'un dispositif à écran tactile affichant une interface graphique utilisateur comprenant une zone tactile non structurée. L'écran tactile peut être configuré pour recevoir une variété d'entrées sous la forme de gestes tactiles dans la zone tactile non structurée et pour interpréter les gestes en signaux électroniques, la zone tactile non structurée comprenant au moins une région ne présentant pas de caractéristiques pouvant être sélectionnées individuellement. Le dispositif comprend aussi un processeur destiné à recevoir les signaux électroniques provenant de la zone tactile et à traduire les signaux au moins en paramètres de position, de mouvement, de durée. Une interface de communication est fournie en plus pour recevoir les paramètres provenant du processeur et pour envoyer les paramètres à un dispositif devant être commandé à distance pour l'interprétation. L'interface de communication peut utiliser au moins un protocole pouvant être utilisé dans un mode essentiellement unidirectionnel, pour envoyer les paramètres au dispositif commandé à distance, moyennant quoi aucune confirmation d'entrée n'est reçue sur le dispositif de commande à distance.

Certains modes de réalisation exposent un procédé qui consiste à commander à distance une application sélectionnée à partir d'une multitude d'applications possibles sur le même dispositif à distance ou d'une multitude de télécommandes différentes. Les données représentatives d'entrées tactiles peuvent être reçues dans une partie non structurée d'une interface à écran tactile. Les données peuvent être reçues par un dispositif commandé à distance ou par un dispositif hébergeant une application commandée à distance et interprétées en une série d'événements disponibles, reconnaissables par le dispositif commandé à distance ou l'application commandée à distance. Une GUI associée à un contexte peut être mise à jour sur la base des événements disponibles. La mise à jour peut intervenir en réponse à la sélection d'un événement à partir d'une série d'événements disponibles, reconnaissables par l'application commandée à distance, sélectionnée sur la base du contexte associé à la GUI affichée.

BRÈVE DESCRIPTION DES DESSINS

Pour mieux décrire la manière dont les modes de réalisation décrits ci-dessus sont mis en œuvre et pour définir d'autres avantages et caractéristiques de l'invention exposée, une description plus précise est fournie ci-après et illustrée par les dessins ci-joints.

R. 42(1)d)

Brève description des dessins

Sachant que ces dessins représentent uniquement des modes de réalisation donnés à titre d'exemple et ne doivent donc pas être considérés comme limitant la portée de l'invention, les exemples seront décrits et expliqués avec des détails et spécificités supplémentaires tout en utilisant les dessins qui les accompagnent dans lesquels :

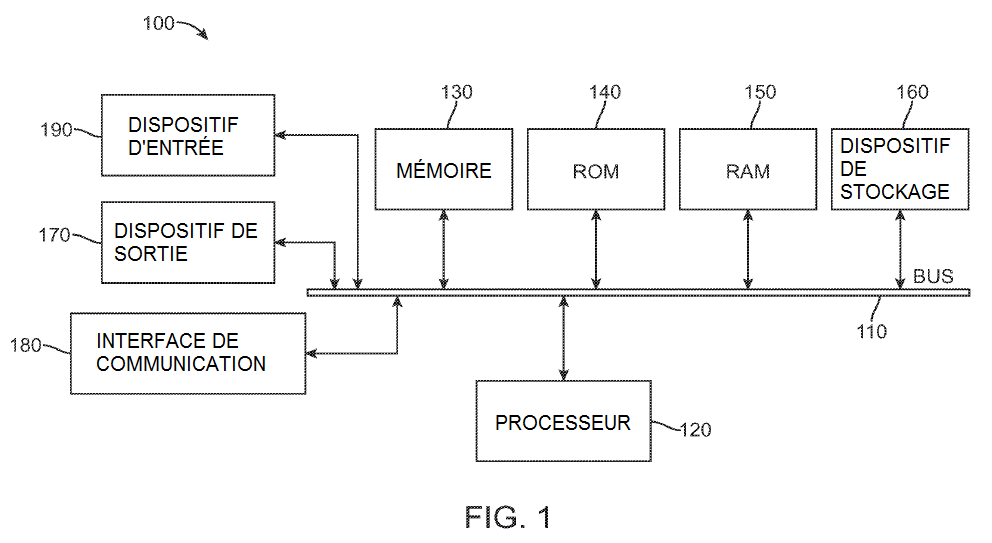

la figure 1 représente un exemple de dispositif informatique ;

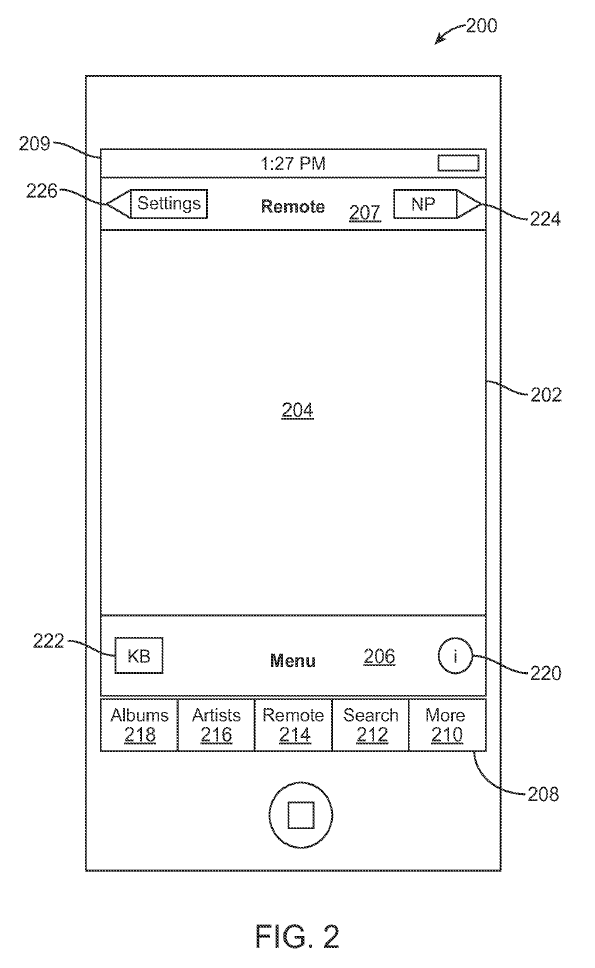

la figure 2 représente un exemple de réalisation de l'interface d'un dispositif de commande à distance ;

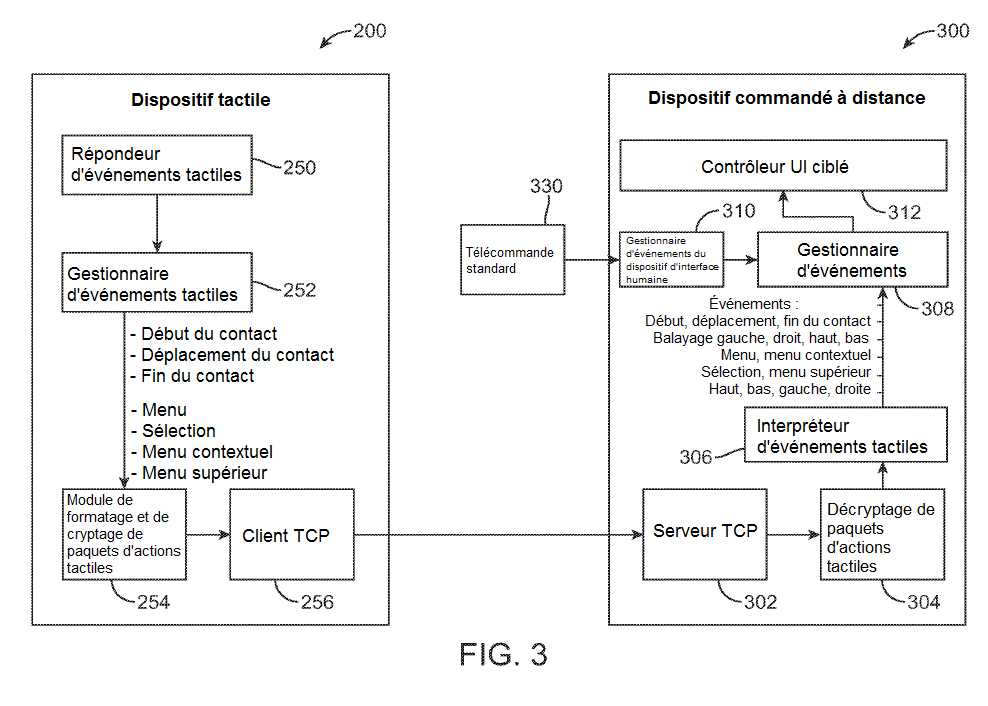

la figure 3 représente un exemple de réalisation d'un système de diagramme fonctionnel ;

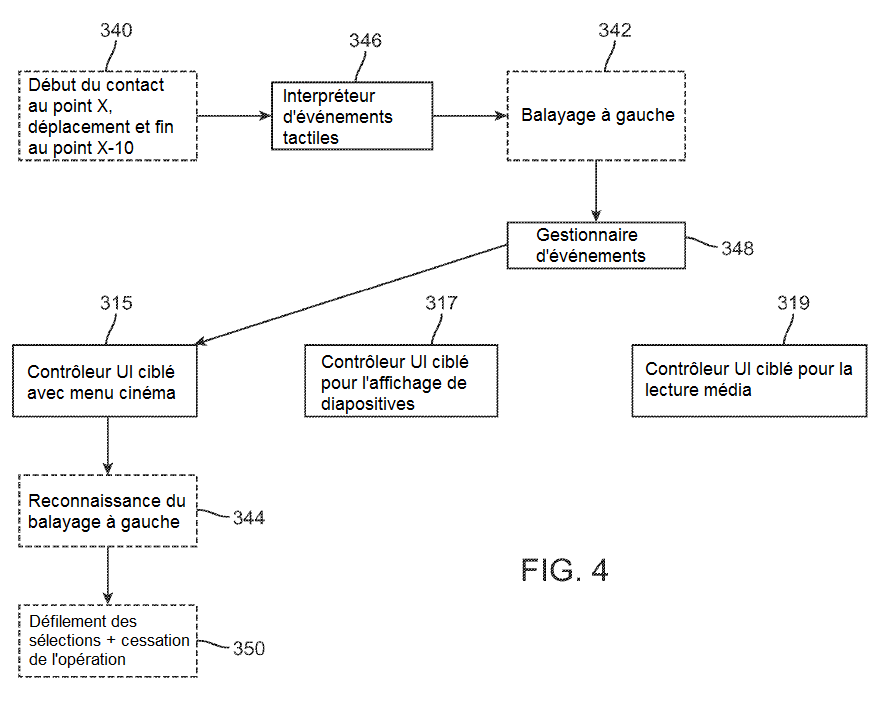

la figure 4 représente un exemple d'organigramme d'un mode de réalisation fonctionnel d'un contrôleur d'interface utilisateur (UI) ciblé ;

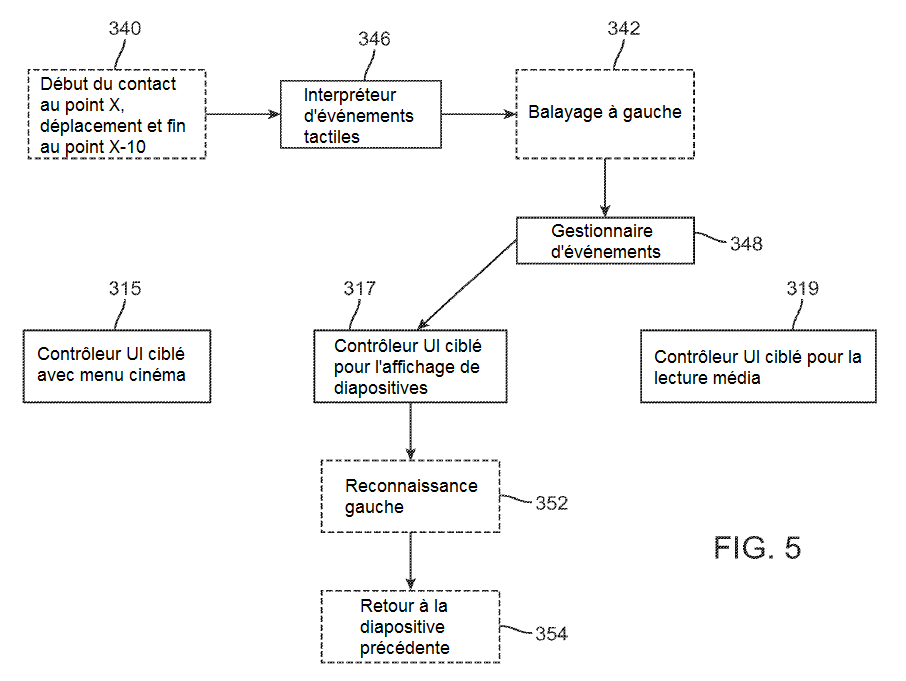

la figure 5 représente un exemple d'organigramme d'un mode de réalisation fonctionnel d'un contrôleur d'interface utilisateur (UI) ciblé ;

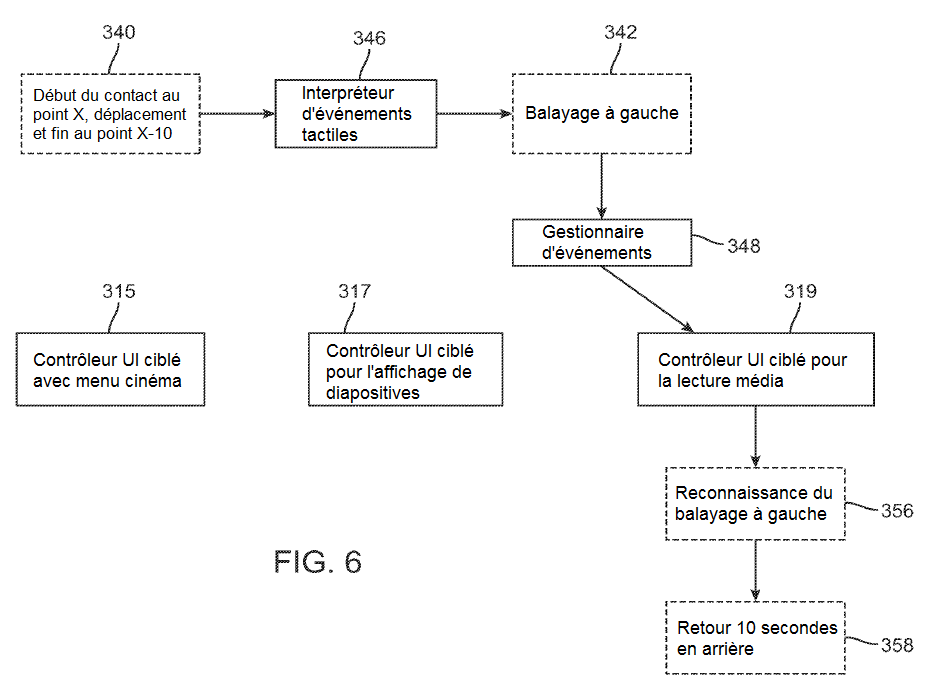

la figure 6 représente un exemple d'organigramme d'un mode de réalisation fonctionnel d'un contrôleur d'interface utilisateur (UI) ciblé ;

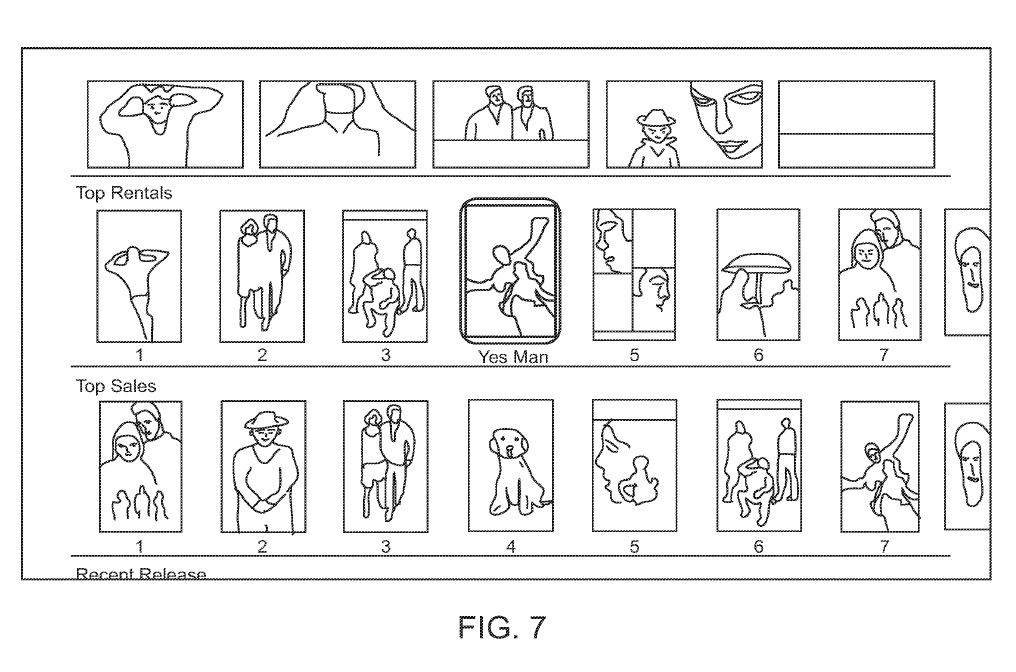

la figure 7 représente un exemple de mode de réalisation de l'interface graphique utilisateur avec menu ;

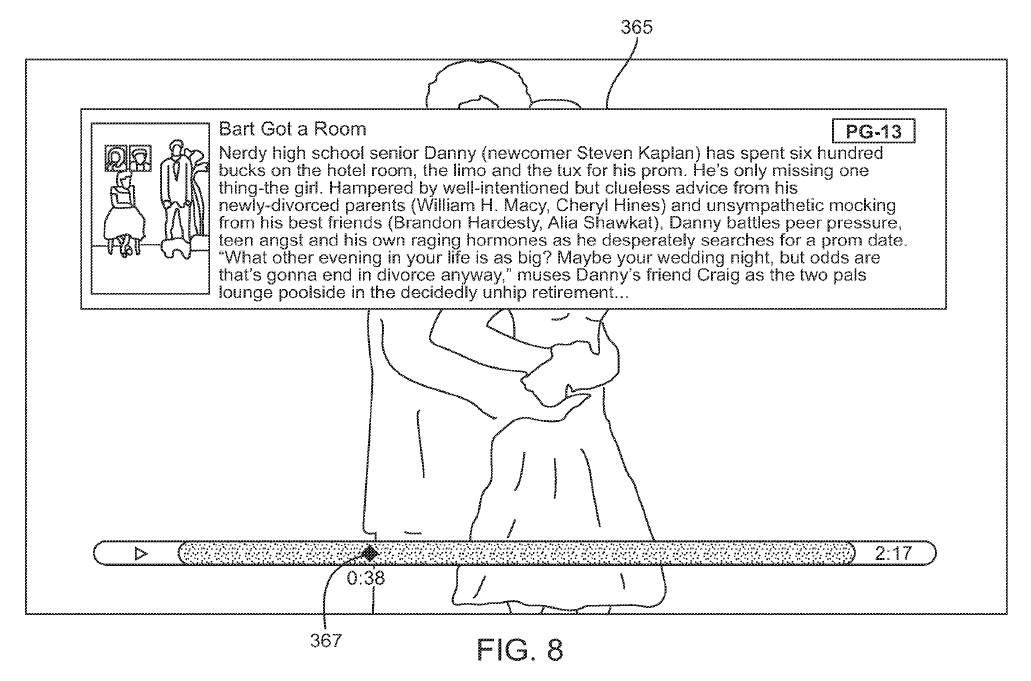

la figure 8 représente un mode de réalisation de l'interface graphique utilisateur avec lecture média ;

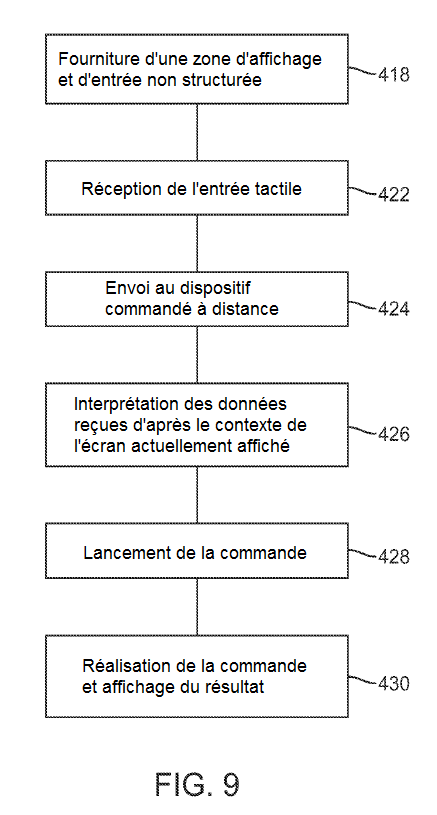

la figure 9 représente un exemple de mode de réalisation du procédé ; et

la figure 10 représente un exemple de mode de réalisation de l'interface pour un dispositif de commande à distance.

DESCRIPTION DÉTAILLÉE

Divers modes de réalisation des procédés et configurations exposés sont présentés en détail ci-après. Même s'il est question de mises en œuvre spécifiques, il faut savoir que celles-ci ne sont données qu'à titre d'exemple. Un homme du métier reconnaîtra que d'autres composants, configurations et étapes peuvent être utilisés sans que l'on se détourne de l'esprit et de l'objet de l'exposé.

R. 42(1)e)

Description d'au moins un mode de réalisation de l'invention

La figure 1 représente un dispositif informatique à usage général 100 pouvant être portable ou fixe. Le dispositif informatique à usage général peut convenir pour procéder aux modes de réalisation décrits ou, dans certains modes de réalisation, deux ou plusieurs dispositifs informatiques à usage général peuvent communiquer entre eux pour procéder aux modes de réalisation décrits ci-dessous. Le dispositif informatique à usage général 100 est présenté avec une unité de traitement (CPU) 120 et un bus système 110 qui relie les différents composants système, notamment la mémoire système telle que la mémoire morte (ROM) 140 et la mémoire vivre (RAM) 150 à l'unité de traitement 120. Une autre mémoire système 130 peut être disponible pour utilisation également. Il est à noter que le système peut fonctionner sur un dispositif informatique ayant plus d'une CPU 120 ou sur un groupe ou une grappe de dispositifs informatiques reliés entre eux en réseau afin de fournir une plus grande capacité de traitement. Le bus système 110 peut répondre à l'un ou l'autre des types de structures de bus suivants : bus mémoire ou contrôleur de mémoire, bus périphérique et un bus local utilisant une variété d'architectures de bus. Une entrée/sortie de base (BIOS) stockée dans la ROM 140 ou équivalente peut délivrer le programme de base permettant de transférer les informations entre des éléments situés à l'intérieur du dispositif informatique 100, par exemple pendant le démarrage. Le dispositif informatique 100 comprend par ailleurs des dispositifs de stockage tels qu'un disque dur 160, un lecteur de disque magnétique, un lecteur de disque optique, un lecteur de bandes ou équivalent. Le dispositif de stockage 160 est relié au bus système 110 par une interface de commande. Les lecteurs et les supports correspondants lisibles par machine fournissent un stockage non volatile d'instructions lisibles par machine, de structures de données, de modules de programme et d'autres données pour le dispositif informatique 100. D'un côté, un module matériel exécutant une fonction particulière comprend le composant logiciel stocké sur un support physique lisible par machine, relié aux composants matériels nécessaires tels que la CPU, le bus, l'affichage, etc., pour réaliser la fonction. Les composants de base sont connus des hommes du métier et des variantes appropriées sont envisagées en fonction du type de dispositif, par exemple selon qu'il s'agit d'un dispositif informatique portable, de petite taille, d'un ordinateur de bureau ou d'un serveur informatique de grande taille.

Bien que l'environnement décrit ici à titre d'exemple utilise un disque dur, les hommes du métier noteront que d'autres types de supports lisibles par machine, capables de stocker des données accessibles par un ordinateur, tels que des cassettes magnétiques, cartes de mémoire flash, disques numériques polyvalents, cartouches, mémoires vives (RAM), mémoire morte (ROM), puissent aussi être utilisés dans l'environnement d'exploitation donné à titre d'exemple.

Pour permettre les échanges entre l'utilisateur et le dispositif informatique 100, le dispositif d'entrée 190 représente un nombre quelconque de mécanismes d'entrée : microphone pour la parole, écran tactile pour les gestes et les entrées graphiques, clavier, souris, entrée de mouvement, parole, etc. Le dispositif de sortie 170 peut être constitué aussi d'un ou de plusieurs mécanismes de sortie connus des hommes du métier. Il s'agit généralement, par exemple, de dispositifs de sortie vidéo ou audio pouvant être reliés à – ou inclure – des affichages ou des haut-parleurs. En plus, les dispositifs de sortie vidéo et audio peuvent également inclure des processeurs spécialisés pour une meilleure performance de ces fonctions spécialisées. Dans certains cas, des systèmes multimodaux permettent à l'utilisateur de délivrer plusieurs types d'entrée pour communiquer avec le dispositif informatique 100. L'interface de communication 180 dirige et gère généralement l'entrée de l'utilisateur et la sortie du système. Il n'existe aucune restriction quant aux procédés exposés et aux dispositifs fonctionnant selon une configuration matérielle particulière. Les fonctions de base peuvent donc être facilement remplacées pour une meilleure configuration matérielle ou micrologicielle pendant leur développement.

Pour des raisons de clarté de l'explication, le mode de réalisation du système fourni à titre d'exemple est présenté comme comprenant des blocs fonctionnels individuels (y compris des blocs fonctionnels étiquetés "processeur"). Les fonctions représentées par ces blocs peuvent être assurées grâce à l'utilisation de matériel soit partagé soit dédié, comprenant entre autres du matériel capable d'exécuter du logiciel. Par exemple, les fonctions d'un ou plusieurs processeurs présentés sur la figure 1 peuvent être assurées par un processeur unique partagé ou par plusieurs processeurs. (Il convient de ne pas utiliser le terme "processeur" pour désigner exclusivement du matériel capable d'exécuter du logiciel.) Les modes de réalisation présentés à titre d'exemple peuvent comprendre un microprocesseur et/ou un processeur de signal numérique (DSP), une mémoire morte (ROM) pour stocker le logiciel exécutant les opérations présentées ci-dessus, et une mémoire vive (RAM) pour stocker les résultats. Des modes de réalisation du matériel avec intégration à très grande échelle (VLSI) ainsi que des circuits VLSI à la demande, associés à un circuit DSP d'utilité générale, peuvent également être fournis.

Les opérations logiques des différents modes de réalisation peuvent être mises en œuvre sous la forme : (1) d'une suite d'étapes, d'opérations ou de procédures mises en œuvre par ordinateur, exécutées sur un circuit programmable à l'intérieur d'un ordinateur d'usage général, (2) d'une suite d'étapes, d'opérations ou de procédures mises en œuvre par ordinateur, exécutées sur un circuit programmable à usage spécifique ; et/ou (3) de modules machine ou de moteurs de programmes reliés entre eux à l'intérieur des circuits programmables.

Le système et le procédé présentés sont particulièrement utiles pour commander un dispositif à distance avec un ou plusieurs menus via une interface tactile à distance comportant au moins une zone d'entrée principale non structurée. Un utilisateur peut fournir des entrées à une interface tactile sans avoir besoin de regarder l'interface et pourtant obtenir la réaction souhaitée de la part du dispositif commandé à distance. La zone d'entrée principale de l'interface tactile peut avoir ou ne pas avoir d'affichage de fond tel qu'un écran tactile type, mais la zone d'entrée principale de l'interface tactile devrait être une zone non structurée. En d'autres termes, dans les modes de réalisation préférés, la zone d'entrée principale de l'interface tactile ne devrait pas avoir d'éléments, de boutons, d'icônes ou d'équivalents pouvant être sélectionnés indépendamment. L'interface tactile n'étant pas structurée, l'utilisateur n'a pas à identifier de boutons pouvant être sélectionnés. Au contraire, il peut entrer un geste dans l'interface et regarder le dispositif réagir. Dans certains modes de réalisation, le système ne fournit aucune autre confirmation visuelle.

La figure 2 présente à titre d'exemple un mode de réalisation de la télécommande. La télécommande 200 telle qu'elle est présentée exécute une application ou un autre programme informatique qui fournit l'interface. Ce mode de réalisation, la télécommande 200, est représenté comme ayant une interface à écran tactile 202. Cependant, l'interface pourrait être n'importe quelle interface tactile, par exemple : un pavé tactile muni de capteurs capacitifs. Par ailleurs, la télécommande en elle-même peut être une télécommande dédiée ou un dispositif électronique portable ayant d'autres fonctions, tel qu'un smartphone, un lecteur de musique portable ou un PDA.

L'interface tactile 202 comprend une zone tactile principale 204, laquelle peut recevoir la majorité des entrées tactiles de l'utilisateur. Dans le mode de réalisation représenté, l'interface tactile comprend également d'autres zones tactiles : une zone de menu 206, une barre de navigation 207, une barre d'onglets 208 et une barre d'état 209.

La zone tactile principale 204 est une zone non structurée, ne comportant pas d'éléments pouvant être sélectionnés individuellement comme des boutons ou des icônes. Par ailleurs, comme la zone 204 n'est pas structurée, il n'y a pas d'éléments à sélectionner ou à éviter. La zone tactile principale est donc particulièrement adaptée pour entrer des éléments dans la télécommande sans avoir nécessairement à la regarder. L'utilisateur peut plutôt regarder le dispositif commandé à distance pour observer sa réaction.

Pour commencer par la barre de navigation 207, deux boutons pouvant être sélectionnés indépendamment l'un de l'autre sont affichés. Le bouton retour 226, appelé ici "Settings" (Paramètres) parce que dans cet exemple l'utilisateur peut revenir au menu Paramètres, peut être sélectionné pour revenir à l'écran précédent. Ce bouton peut être appelé différemment selon le nom de l'écran auquel l'utilisateur reviendra s'il sélectionne ce bouton. Le bouton 224 agit comme un bouton suivant, mais dans la plupart des cas, il amène l'utilisateur à l'"écran de lecture en cours" (NP pour "Now Playing Screen"), présent lorsque le dispositif commandé à distance lit une séquence audio ou vidéo. Il convient de noter, ici et dans l'ensemble du document, que même si, comme indiqué, de nombreux boutons de l'interface de la télécommande sont désignés par un nom spécifique, les étiquettes correspondantes ne se veulent pas limitatrices.

La zone de menu 206 dans son ensemble est une zone tactile qui enregistre des entrées visant à revenir au menu précédent suite aux tapotements effectués dans la zone de menu, ou à revenir au menu de niveau supérieur après réception et détection d'une action d'appui et de maintien appuyé. Le mode de réalisation présenté comporte deux autres boutons. Le bouton clavier 222 et le bouton information 220 peuvent être affichés lorsque l'on en a besoin et ne pas être affichés lorsque l'on n'en a pas besoin. Par exemple, lorsqu'un clavier est présent sur l'interface utilisateur du dispositif commandé à distance, le bouton clavier 222 peut apparaître. Le fait de sélectionner le bouton clavier 222 fait apparaître un clavier sur la télécommande, facilitant la frappe dans l'interface du dispositif commandé à distance. De même, le bouton information 220 peut être affiché lorsque des informations sont disponibles sur un élément affiché sur l'interface du dispositif commandé à distance.

Les boutons 220 et 222 sont situés près des bordures extérieures de la zone de menu 206 et de l'écran 202 en général. Le fait de placer les boutons 220 et 222 à l'angle de l'interface permet d'éviter les sélections non intentionnelles, car il est rare qu'un utilisateur touche malencontreusement l'un des angles du dispositif.

Dans certains modes de réalisation, la télécommande 200 peut être un téléphone mobile, un smartphone, un lecteur multimédia portable, un PDA ou un autre dispositif informatique portable assurant diverses fonctions. Dans ces modes de réalisation, une barre d'onglets 208 peut être utile pour naviguer dans les autres fonctions disponibles sur la télécommande. La barre d'onglets 208 peut être une zone tactile structurée avec des boutons pouvant être sélectionnés à cet effet. Par exemple, le bouton 218 peut donner l'instruction à la télécommande 200 de passer au menu "Albums", le bouton 216 au menu "Artists", le bouton 212 à l'écran "Search" (Recherche). Le bouton 210 peut fournir des options supplémentaires. Le bouton 214 "Remote" (Télécommande) permet de revenir à l'interface de télécommande.

Dans certains modes de réalisation, l'une des zones 206, 207, 208 ou 209 ou l'ensemble d'entre elles sont absentes de l'interface de télécommande. Dans certains autres modes de réalisation, les zones 206, 207, 208 et 209 peuvent ignorer les entrées réalisées dans certaines conditions et ainsi éviter les sélections non intentionnelles. Par exemple, lorsque la télécommande est tenue en grande partie horizontalement, il est possible de rendre non sélectionnables toutes les entrées pouvant être sélectionnées individuellement. À l'inverse, lorsque la télécommande est tenue selon un angle en grande partie vertical, il est possible de rendre sélectionnables les entrées pouvant être sélectionnées individuellement.

Dans certains modes de réalisation, un procédé visant à éviter toute sélection non intentionnelle nécessite une action de sélection à la fois au début et à la fin de la zone pouvant être sélectionnée individuellement. Par exemple, pour activer la zone de menu, le contact tactile doit commencer et se terminer à l'intérieur de la zone de menu 206. Si un contact tactile commence ou se termine en dehors de la zone de menu mais dans la zone tactile principale 204, l'entrée peut être considérée comme une entrée de type généralement connu et détecté dans la zone tactile principale 204.

Comme le montre la figure 3, le dispositif tactile 200 reçoit des événements tactiles de l'utilisateur, entrés via un répondeur d'événements tactiles 250, lequel transmet les événements tactiles au gestionnaire d'événements tactiles 252. Le gestionnaire d'événements tactiles 252 interprète les événements tactiles reçus par le répondeur d'événements tactiles 250 afin d'identifier les informations relatives à l'événement tactile. Par exemple, le gestionnaire d'événements tactiles peut identifier les pixels où le contact a démarré et où il s'est terminé et déterminer le mouvement du contact. Ce gestionnaire interprète également la durée de l'événement tactile. Le gestionnaire d'événements tactiles 252 peut interpréter si le contact a donné lieu à une entrée de menu, une action de sélection, une entrée de menu contextuel ou une entrée de menu supérieur. Ces informations sont constituées en paquets et cryptées par le module de formatage et de cryptage des paquets d'actions tactiles 254 et envoyées par le client TCP 256 au dispositif commandé à distance 300.

La figure 3 présente un client TCP 256 permettant de transférer des données de la télécommande 200 vers le dispositif commandé à distance 300, mais tout protocole peut être utilisé pour envoyer des données de 200 vers 300. Cependant, dans ce mode de réalisation, le protocole TCP est envisagé pour ses avantages en termes de vitesse. Le protocole TCP peut être configuré de manière essentiellement unidirectionnelle, sans nécessiter de mouvement des mains ni autre communication non nécessaire pouvant augmenter le temps d'attente dans la transmission de données de la télécommande vers le dispositif commandé à distance. Il est à noter que quelle que soit la technologie retenue - connexion directe de dispositif à dispositif ou réseau local - celle-ci permet de délivrer de manière relativement rapide et fiable les informations envoyées par le dispositif tactile 200.

En outre, pour une transmission rapide des commandes, du dispositif tactile 200 vers le dispositif commandé à distance 300, la quantité de données envoyées devrait être limitée au minimum. Dans certains modes de réalisation, la quantité de données transférées est d'environ 20 octets jusqu'à environ 50 octets par paquet. S'il peut être noté que l'interface tactile du dispositif tactile 200 est un instrument universel et est capable d'enregistrer et d'interpréter des données dans des instructions plus complexes pour la télécommande, la complexité n'est toutefois pas avantageuse. Au contraire, le dispositif tactile 200 enregistre et transmet des informations simples.

Dans le contexte d'une commande à distance, il est important que les commandes provenant de la télécommande 200 soient rapidement transmises et reçues par le dispositif de commande à distance 300. Par conséquent, dans le mode de réalisation présenté à la figure 3, la télécommande envoie en grande partie des données génériques à partir du dispositif tactile et laisse le dispositif commandé à distance 300 interpréter les données. Par exemple, le serveur TCP 302 reçoit les données transmises via le protocole TCP en provenance du client TCP 256, et les données sont décryptées avec le module 304.

Les données tactiles génériques (début du contact, déplacement, fin, durée/vélocité) peuvent être interprétées par un interpréteur tel que l'interpréteur d'événements tactiles 306. Ce dernier traduit les données génériques des événements tactiles en événements compréhensibles et utilisables par le dispositif commandé à distance 300. Dans cet exemple, les informations telles que le début du contact tactile, le déplacement et la fin, enregistrés par la télécommande 200, peuvent être traduites en événements, gauche, droite, haut, bas, balayage à gauche, balayage à droite, balayage vers le haut, balayage vers le bas, ou interprétées de manière générique comme le début du contact tactile, le déplacement ou la fin.

Un gestionnaire d'événements 308, qui peut recevoir les entrées et les transmettre à un contrôleur pour une interface graphique utilisateur, est également représenté. Comme indiqué, le gestionnaire d'événements 308 peut recevoir des événements provenant d'une télécommande standard 330, lesquels ont été reçus et interprétés par le gestionnaire d'événements du dispositif d'interface humaine 310, et peut recevoir aussi des événements provenant du dispositif tactile 200, qui ont été interprétés par l'interpréteur d'événements tactiles 306.

Un ou plusieurs contrôleurs d'interface utilisateur (contrôleurs UI) contrôlent chaque interface graphique utilisateur du dispositif commandé à distance. Comme indiqué sur la figure 3, le contrôleur UI est appelé contrôleur UI ciblé 312 parce qu'il représente le contrôleur UI qui est associé à l'interface graphique utilisateur affichée actuellement par le dispositif commandé à distance. S'il peut y avoir un grand nombre de contrôleurs IU, le contrôleur UI ciblé est néanmoins le contrôleur associé à l'écran de l'interface graphique utilisateur affiché actuellement.

Le contrôleur UI ciblé 312 reçoit les événements provenant du gestionnaire d'événements 308. Il reçoit toutes les entrées possibles et réagit à toute entrée que sa configuration lui permet d'accepter.

Les figures 4 à 6 montrent comment différents contrôleurs UI ciblés traitent le même ensemble d'événements tactiles. Sur 340, un utilisateur entre un geste qui démarre à un point arbitraire X de l'interface tactile et se termine au point X-10 qui est à gauche de X, et le geste tactile a une certaine vélocité. L'entrée tactile est reçue, traitée et envoyée au dispositif commandé à distance, comme décrit ci-dessus. Dans le dispositif commandé à distance, l'interpréteur d'événements tactiles 346 reçoit les données descriptives de l'événement tactile et peut traduire les données en événements 342, lesquels peuvent être reconnus par le dispositif commandé à distance. Dans cet exemple, l'interpréteur d'événements tactiles délivre un événement de balayage à gauche et un événement à gauche.

Le gestionnaire d'événements 348 transmet l'événement à gauche et l'événement de balayage à gauche au contrôleur UI qui est actuellement "ciblé". Un contrôleur UI est dit "ciblé" lorsqu'il contrôle au moins une partie de l'écran de l'interface utilisateur affiché. Le contrôleur UI ciblé reçoit les événements du gestionnaire d'événements 348. Sur les figures 4 à 6, il existe trois contrôleurs UI ciblés différents : le contrôleur UI ciblé avec menu cinéma 315, le contrôleur UI ciblé pour l'affichage de diapositives 317 et un contrôleur UI ciblé pour la lecture média 319. Sur la figure 4, le contrôleur UI ciblé avec menu cinéma 315 reçoit les événements tactiles 342 du gestionnaire d'événements 348 et reconnaît le balayage à gauche (344) et a pour effet que l'UI fait défiler les sélections et cesse l'opération de défilement (350). Sur la figure 5, le contrôleur UI ciblé pour l'affichage de diapositives 317 est le contrôleur actif et reconnaît l'événement à gauche (352), lequel entraîne un retour de l'interface utilisateur à la diapositive précédente dans l'affichage des diapositives (354). Sur la figure 6, le contrôleur UI ciblé pour la lecture média 319 est le contrôleur actif et reconnaît l'événement de glisser à gauche (356), lequel entraîne un retour de l'interface utilisateur à la diapositive précédente dans l'affichage des diapositives (358). Ensemble les figures 4 à 6 montrent comment la même entrée tactile peut être reconnue comme plusieurs événements différents et comment les contrôleurs UI ciblés choisissent parmi ces événements pour générer une action dans l'interface utilisateur.

Si, dans les exemples présentés aux figures 4 à 6, les contrôleurs UI ciblés ne reconnaissent qu'un des deux événements entrés, il peut arriver néanmoins que le contrôleur UI ciblé reconnaisse plusieurs événements comme étant liés à des actions. Par exemple, le contrôleur du menu cinéma peut avoir reconnu à la fois l'événement de balayage et l'événement à gauche. Dans ce cas, le contrôleur UI ciblé peut être configuré pour choisir un événement plutôt qu'un autre si plusieurs événements sont reconnus.

À ce stade, il convient de comparer à titre informatif comment la technologie décrite actuellement fonctionne par rapport à une télécommande standard 330, représentée sur la figure 3. Un moyen de conceptualiser la télécommande 200 est de mettre au point une télécommande universelle pouvant délivrer les mêmes données quel que soit le dispositif avec lequel elle communique. Il s'agit d'une télécommande munie d'une interface non structurée et par conséquent tout geste ou toute commande peut être entré(e). La télécommande 330, en revanche, est spécifique au dispositif commandé à distance. Pour les besoins de cette discussion, la télécommande est une télécommande simple, munie seulement d'un bouton de menu et des directions haut, bas, gauche et droite. Le dispositif commandé à distance est configuré pour accepter les entrées de la télécommande 330 et chaque entrée est liée à une fonction sur le dispositif commandé à distance. Même une télécommande universelle traditionnelle est programmée pour fonctionner de la même manière que la télécommande 330, émettant des commandes spécifiques au dispositif commandé à distance.

Les entrées venant du dispositif tactile 200 sont reçues par l'interpréteur d'événements tactiles 306, lequel peut traduire les données tactiles en événements tactiles pouvant être potentiellement utilisés par le dispositif à distance. Le gestionnaire d'événements 308 transmet les événements au contrôleur UI ciblé 312. Une entrée venant de la télécommande standard 330 peut être reçue par le gestionnaire d'événements du dispositif d'interface humaine 310 et traduite en un événement pouvant être utilisé par le dispositif tactile. Comme avec les événements reçus en provenance du dispositif tactile 200, le gestionnaire d'événements 308 peut transmettre la commande, de la télécommande standard 330 au contrôleur UI ciblé 312.

Dans certains modes de réalisation, le contrôleur UI ciblé 312 peut être configuré pour accepter des entrées supplémentaires, au-delà de ce qui est possible avec la télécommande standard 330. Dans de tels modes de réalisation, le contrôleur UI ciblé 312 peut choisir parmi les entrées qu'il souhaite accepter. Dans ces modes de réalisation, le contrôleur UI ciblé 312 est configuré pour faire ce choix. Par exemple, le contrôleur UI ciblé 312 peut être informé qu'il est en train de recevoir des événements provenant du dispositif tactile 200 et considérer ces commandes préférables à des entrées simplistes telles qu'un événement à gauche, fourni par la télécommande standard 330. Dans ce cas, si le contrôleur UI ciblé 312 recevait des événements en provenance du dispositif tactile 200, il lui faudrait choisir aussi bien l'événement simple que l'événement de plus haut niveau tels qu'un balayage, car les deux sont représentés. Le contrôleur UI ciblé 312 peut apprendre que les données proviennent du dispositif tactile 200 et choisir de transmettre rapidement un film basé sur l'entrée par balayage, plutôt que de sauter un chapitre du film basé sur l'événement à gauche.

Tout comme il peut être configuré pour accepter différentes commandes basées sur le dispositif recevant les commandes, le contrôleur UI ciblé 312 peut aussi interpréter les commandes basées sur le contexte de l'interface actuellement affichée. Comme mentionné ci-dessus, chaque contrôleur UI ciblé est spécifique à un contexte différent. Il est possible d'avoir beaucoup plus de contrôleurs UI, chacun responsable de leur propre fonction. Comme chaque contrôleur UI est responsable d'une partie différente de l'UI ou d'un écran différent ayant un contexte différent, chaque contrôleur UI ciblé peut réaliser différentes fonctions à partir de la même entrée.

Comme expliqué précédemment, un utilisateur peut fournir une variété d'entrées dans la zone tactile principale 204 mais le résultat de ces entrées peut varier en fonction du contexte dans lequel l'entrée est donnée. Le contrôleur UI ciblé, spécifique à une interface graphique utilisateur (GUI) en particulier, peut être programmé pour interpréter des entrées basées sur des éléments ou caractéristiques de son contexte. Par exemple, pour contrôler à distance une application multimédia exécutée sur une télécommande, il est possible d'avoir au moins un contexte de menu (figure 7) et un contexte de lecture media (figure 8), chacun ayant son propre contrôleur UI ciblé pour surveiller son comportement. Si la commande d'une application multimédia à distance est présentée comme un exemple de mode de réalisation, beaucoup d'autres dispositifs peuvent aussi être commandés selon les concepts présentés ici, entre autres : télévisions, boîtiers de connexion par câble, enregistrements vidéo numériques, lecteurs de disques numériques (DVD, CD, HD-DVD, Blu-Ray etc.).

Pour revenir à l'exemple d'une application multimédia exécutée sur une télécommande – dans un contexte de menu, un utilisateur peut éventuellement naviguer dans les médias, par titre, artiste, type de média, sélections de morceaux, nom d'album, genre (il convient de comprendre que certaines de ces catégories de navigation dans les médias sont plus ou moins applicables à différents types de médias, par exemple : films ou chansons). Dans l'exemple représenté sur la Figure 7, l'utilisateur peut naviguer dans l'interface de menu, parmi les titres de films organisés sous forme de liste. Dans le contexte de menu, différentes entrées peuvent être saisies dans la zone tactile principale pour naviguer dans le menu et procéder à une sélection. Par exemple, comme indiqué dans le tableau ci-dessous, un utilisateur peut faire glisser l'interface dans une direction souhaitée, ce qui peut entraîner une opération de défilement. Selon l'état de l'art, la vitesse du geste et l'opération de défilement peuvent être liées. Par exemple, un geste de balayage plus rapide peut entraîner une opération de défilement plus rapide et/ou un défilement de plus longue durée. En outre, la zone tactile principale peut également recevoir des tapotements, qui peuvent sélectionner un élément. Par ailleurs, en déplaçant son doigt sur la zone tactile principale 204, l'utilisateur peut déplacer un élément sélectionné ou mis en surbrillance.

TABLEAU 1

Contexte de navigation dans un menu |

|

Action tactile |

Résultat |

Glissement unique d'un doigt dans la direction souhaitée |

Déplacement de la sélection |

Balayage unique d'un doigt dans la direction souhaitée |

Défilement des sélections et cessation de l'opération |

Tapotement unique d'un doigt dans la zone de sélection principale |

Sélection d'un élément |

Un grand nombre d'actions peuvent aboutir à différents résultats ou à différentes actions menées sur ou par le dispositif commandé à distance dans d'autres contextes. Par exemple, comme exposé sur le graphique ci-dessous, plusieurs actions identiques, décrites ci-dessus, peuvent générer des résultats différents dans le contexte de lecture média représenté sur la figure 8. Un seul tapotement du doigt dans la zone tactile principale peut entraîner la lecture ou la pause dans le contexte d'une lecture média, contrairement à une sélection dans le contexte d'un menu. De même, une action de glissement peut entraîner une opération sur la barre d'avancement 367. Un balayage à droite et un balayage à gauche peuvent entraîner un avancement rapide respectivement vers la droite et vers la gauche, contrairement à l'opération de défilement dans le contexte d'un menu. Un balayage vers le haut peut entraîner l'affichage cyclique 365 de diverses informations que le lecteur média peut avoir à sa disposition. Un balayage vers le bas peut générer l'affichage d'un menu permettant de sélectionner un chapitre.

TABLEAU 2

Contexte de lecture média |

|

Action tactile |

Résultat |

Tapotement unique d'un doigt dans la zone de sélection |

Bascule lecture/pause |

Glissement unique d'un doigt à gauche / à droite |

Déplacement de la barre d'avancement à gauche / à droite |

Balayage du doigt vers la gauche |

Retour 10 secondes avant |

Balayage du doigt vers la droite |

Avancée à 10 secondes après |

Balayage du doigt vers le haut |

Affichage cyclique d'informations |

Balayage du doigt vers le bas |

Menu de sélection de chapitre |

D'autres entrées ne varient pas nécessairement en fonction du contexte. Par exemple, un tapotement dans la zone de menu 206 permet de revenir à l'écran de menu précédent. Le maintien du doigt dans la zone de menu permet de revenir au menu supérieur. Certaines entrées dans la zone tactile principale 204 entraîneront toujours la même action : le maintien de deux doigts appuyés dans la zone tactile principale 204 permettra de revenir au menu dans le contexte en cours d'affichage sur le dispositif.

TABLEAU 3

Tout contexte |

|

Action tactile |

Résultat |

Tapotement unique d'un doigt dans la zone de menu |

Menu |

Maintien unique d'un doigt appuyé dans la zone de menu |

Menu supérieur |

Maintien de deux doigts appuyés dans la zone de sélection principale |

Menu contextuel |

Beaucoup d'autres entrées sont possibles en plus des diverses entrées tactiles décrites ci-dessus. Rien de ce qui figure dans l'exposé ci-dessus ne doit être considéré comme limitant les entrées ou gestes tactiles possibles avec la technologie décrite. Par exemple, en plus des entrées avec un ou deux doigts, il est possible d'envisager des entrées avec trois ou quatre doigts. En outre, des gestes plus complexes peuvent être utiles, comme la séparation de deux ou plusieurs doigts et des entrées relatives à chacun des doigts. Ces gestes sont déjà connus dans l'état de la technique, comme la rotation d'un doigt autour d'un autre pour faire tourner l'image à l'écran, ou l'écartement ou bien le rapprochement de deux doigts pour agrandir. Beaucoup d'autres sont pris en compte dans les capacités de l'homme du métier.

Par ailleurs, le terme "doigt" utilisé ci-dessus et dans l'ensemble du fascicule n'est pas censé être limitatif non plus. Dans certains modes de réalisation, il fait référence à un doigt humain mais dans d'autres, il peut faire référence à tout ce qui peut être détecté par un dispositif capacitif. Dans certains modes de réalisation, le doigt peut faire référence à un stylet ou à un autre objet permettant d'effectuer des saisies dans un dispositif avec saisie via un affichage.

Une fois que le contrôleur UI ciblé accepte une entrée, il affecte l'UI du dispositif commandé à distance. Dans de nombreux cas, c'est le premier retour que l'utilisateur obtiendra, lui indiquant que c'est la bonne commande qui a été donnée. Une telle boucle de réaction augmente la réactivité du système et ainsi l'interface de la télécommande est moins complexe. Cependant, dans d'autres modes de réalisation, d'autres types de retour peuvent être fournis. Par exemple, un retour sonore peut être fourni à l'utilisateur de manière à ce qu'il ou elle puisse savoir au moins si une commande a été émise. Ou bien la télécommande peut vibrer ou fournir tout autre type de retour souhaité. Le retour peut aussi être spécifique à la commande ; il est possible d'avoir un son différent ou une vibration différente pour chaque commande.

Dans certains modes de réalisation, le dispositif commandé à distance peut ne pas avoir d'interpréteur d'événements. Dans ces modes de réalisation, la télécommande envoie les données représentatives d'entrées tactiles au dispositif commandé à distance et le contrôleur UI ciblé peut être configuré pour interpréter les données.

Dans certains modes de réalisation, il peut être utile de permettre à la télécommande de connaître les changements intervenant dans les menus ou sur les affichages du dispositif de télécommande. Dans ces modes de réalisation, un canal de communication séparé peut être ouvert, par exemple en utilisant un protocole de transfert hypertexte pour transférer des informations entre les dispositifs. Afin de conserver les performances de la télécommande, la plupart des communications peuvent être des communications unidirectionnelles pour une plus grande rapidité, mais des communications bidirectionnelles peuvent être utilisées aussi en cas de besoin. Par exemple, même si la plupart des communications allant de la télécommande vers le dispositif commandé à distance sont transférées via le protocole TCP, les protocoles HTTP ou DAAP peuvent être utilisés aussi pour informer la télécommande de cas spéciaux, par exemple lorsque des informations supplémentaires sont disponibles ou lorsqu'un clavier s'affiche sur le dispositif commandé à distance. Dans ces exemples, un clavier, par exemple, peut s'afficher sur la télécommande et les entrées dans ce clavier peuvent être transférées via le protocole HTTP. De même, lorsque des informations comme celles présentées sur la figure 8 sont disponibles, un bouton d'information peut s'afficher sur la télécommande pour déclencher la fenêtre d'information 365.

La figure 9 représente le procédé de contrôle de la télécommande. À l'étape 418, une application à distance fournit une zone tactile non structurée pour recevoir les entrées tactiles d'un utilisateur. Les entrées tactiles sont reçues et traduites au moins en éléments suivants : début de l'événement tactile, fin de l'événement tactile, données de mouvement et de durée à l'étape 422. Les données sont mises en forme et envoyées au dispositif commandé à distance à l'étape 424.

À l'étape 426, le dispositif commandé à distance interprète les données reçues en ayant connaissance du contexte de l'écran qui s'affiche actuellement sur le dispositif commandé à distance. En fonction des entrées reçues et du contexte de l'affichage actuel, le dispositif commandé à distance interprète les données reçues de la télécommande et accepte la commande à l'étape 428, ce qui amène le dispositif commandé à distance à réaliser la commande et à afficher le résultat à l'étape 430.

Il est à noter que même si la description ci-dessus présente un dispositif de lecture média avec logiciel associé, la technologie s'applique également à d'autres dispositifs commandés à distance tels que les télévisions, DVR, lecteurs de DVD, Blu-Ray, boîtiers de connexion par câble, etc. Par exemple, le dispositif de commande à distance peut être programmé pour accepter et interpréter les données génériques d'interface de l'écran tactile et répondre à ces entrées de données. Ou bien la télécommande elle-même peut être fournie avec des instructions expliquant comment communiquer avec presque tout dispositif commandé à distance. Tant que la télécommande ou le dispositif commandé à distance peut interpréter les données tactiles basées sur le contexte de ce qui est actuellement affiché ou a été amené à être affiché par le dispositif à distance, les principes de la technologie décrite peuvent s'appliquer.

Dans certains modes de réalisation, des zones plus ou moins tactiles sont possibles. Toutefois, les zones tactiles supplémentaires ayant des interfaces structurées augmentent le risque que des commandes non intentionnelles soient entrées dans la télécommande. Les meilleures interfaces fournissent une expérience globale pour les utilisateurs, ces derniers n'ayant pas besoin, dans la plupart des cas, de regarder la télécommande pour procéder à une sélection. Il convient cependant de noter que si l'utilisateur ne regarde pas la télécommande, dans un environnement tactile où le dispositif dans son ensemble semble identique à l'utilisateur, les entrées non intentionnelles sont possibles et peuvent même devenir probables s'il existe trop d'éléments pouvant être sélectionnés individuellement.

Plusieurs procédés peuvent être utilisés pour empêcher les entrées non intentionnelles. L'un d'entre eux, comme décrit ci-dessus, utilise un accéléromètre pour déterminer l'orientation des dispositifs et se base sur le fait que l'orientation détermine le type de commande que l'utilisateur tente d'entrer. Si le dispositif est horizontal, l'utilisateur ne regarde probablement pas le dispositif et les gestes sont vraisemblablement destinés à commander le dispositif commandé à distance. Cependant, si le dispositif est plus vertical ou incliné de manière à ce que l'utilisateur puisse regarder l'écran, l'utilisateur regarde probablement l'écran et les entrées se font plus vraisemblablement par les boutons d'interface structurés. Une autre possibilité est représentée sur la figure 5 où la télécommande 500 est tournée en mode paysage. Dans cette orientation, l'ensemble de l'interface n'est pas structuré et seules la zone de sélection principale 502 et la zone de sélection du menu 504 sont présentes. Ce mode de réalisation éliminerait les entrées non intentionnelles en supprimant la partie structurée de l'interface lorsque l'utilisateur souhaite utiliser uniquement l'interface non structurée pour entrer les gestes tactiles visant à commander le dispositif commandé à distance. Lorsque le dispositif est tourné en mode portrait, une interface structurée peut être disponible. Un autre moyen de réduire les entrées non souhaitées est de tourner la partie de l'affichage de l'écran tactile complètement, quelle que soit l'orientation du dispositif. Dans ces modes de réalisation, seules les entrées non structurées dans la zone de sélection principale et dans la zone de menu seraient disponibles. Si l'utilisateur souhaitait l'une des options structurées, l'écran pourrait être retourné par un mécanisme quelconque d'actionnement comme un bouton matériel, le fait de secouer le dispositif, ou par un geste tactile.

En outre et comme décrit ci-dessus, il est possible d'éviter les entrées non intentionnelles en configurant l'interface tactile pour qu'elle accepte toute entrée dérivant à l'intérieur ou à l'extérieur d'une entrée structurée comme entrée dans l'interface non structurée. De cette manière, seules les sélections délibérées sont enregistrées.

Les modes de réalisation entrant dans le champ d'application de la présente invention peuvent également inclure des supports lisibles par machine sur lesquels sont stockées ou qui exécutent des structures de données ou des instructions exécutables par ordinateur. De tels supports lisibles par machine peuvent être n'importe quels supports disponibles, accessibles via un ordinateur à usage général ou spécifique. Ces supports lisibles par machine peuvent comprendre concrètement, entre autres, la RAM, la ROM, l'EEPROM, des CD-ROM ou d'autres disques optiques, disques magnétiques ou autres dispositifs de stockage magnétique ou tout autre support pouvant être utilisé pour porter ou stocker les codes de programme souhaités, sous la forme de structures de données ou d'instructions exécutables par ordinateur. Lorsque les informations sont transférées ou fournies via un réseau ou une autre liaison de communication (filaire, sans fil ou une combinaison des deux) à un ordinateur, l'ordinateur visualise correctement la liaison comme un support lisible par machine. Ainsi, toute liaison de ce type est appelée, de manière correcte, support lisible par machine. Les combinaisons de ce qui précède devraient aussi faire partie du champ d'application du support physique lisible par machine.

Les instructions exécutables par ordinateur comprennent, par exemple, des données et instructions amenant un ordinateur à usage général, un ordinateur à usage spécial ou un dispositif de traitement à usage spécial à réaliser une certaine fonction ou un certain groupe de fonctions. Les instructions exécutables par ordinateur comprennent également des modules de programme exécutés par des ordinateurs dans des environnements autonomes ou des environnements réseau. De manière générale, les modules de programme comprennent des routines, programmes, objets, composants et structures de données qui exécutent des tâches particulières ou qui mettent en œuvre des types de données abrégées en particulier. Les instructions exécutables par ordinateur, les structures de données associées et les modules de programme représentent des exemples des moyens de code de programme pour exécuter les étapes des procédés qui y sont exposées. La séquence en particulier de ces instructions exécutables ou structures de données associées représente des exemples d'actions correspondantes visant à mettre en œuvre les fonctions décrites dans ces étapes.

Les hommes du métier noteront que d'autres modes de réalisation de l'invention peuvent être mis en pratique dans des environnements informatiques de réseau avec de nombreux types de configurations système, y compris avec les ordinateurs personnels, dispositifs portables, systèmes multiprocesseurs, électroniques basées sur des microprocesseurs ou électroniques de consommation programmables, PC en réseau, mini-ordinateurs, gros ordinateurs, et équivalents. Des modes de réalisation peuvent être aussi mis en pratique dans des environnements informatiques distribués où les tâches sont réalisées par des dispositifs de traitement locaux ou à distance, liés (soit par des liaisons filaires, des liaisons sans fil ou une combinaison des deux) via un réseau de communication. Dans un environnement informatique distribué, les modules de programme peuvent être situés à la fois dans des dispositifs de stockage de mémoire locaux et à distance.

La communication aux différentes étapes du système décrit peut être réalisée via un réseau local, un réseau à jetons, Internet, un Intranet d'entreprise, des signaux sans fil de série 802.11, un réseau à fibres optiques, une transmission radio ou hyperfréquences, etc. Si la technologie de communication sous-jacente peut changer, les principes fondamentaux décrits ici demeurent néanmoins applicables.

Les différents modes de réalisation décrits ci-dessus sont fournis à titre d'exemple uniquement et ne devraient pas être interprétés comme limitant l'invention. Par exemple, les principes énoncés ici peuvent être appliqués à n'importe quel dispositif commandé à distance. Par ailleurs, les hommes du métier reconnaîtront que la communication entre la télécommande et le dispositif contrôlé à distance ne doit pas se limiter à une communication via un réseau local mais qu'elle peut inclure une communication via des canaux infrarouges, Bluetooth ou toute autre interface de communication appropriée. Les hommes du métier reconnaîtront déjà diverses modifications et divers changements qui pourront être apportés à la présente invention sans suivre les modes de réalisation et applications donnés à titre d'exemples et décrits ici, et sans s'écarter du champ d'application du présent exposé.

1. Procédé destiné à commander à distance un dispositif (300), comprenant :

R. 43(1)a)

Le cas échéant, première partie (préambule) de la revendication indépendante

la réception de données d'entrées tactiles dans un dispositif commandé à distance (300) à partir d'une télécommande (200) incluant un écran tactile

(202) et une unité de traitement, les données d'entrées tactiles comprenant des informations incluant des paramètres de position, de mouvement et de durée, où les données d'entrées tactiles peuvent être interprétées par le dispositif commandé à distance (300) comme l'une des multiples commandes potentielles dans un premier contexte d'interface graphique utilisateur (GUI) du dispositif commandé à distance (300) et comme une autre des multiples commandes potentielles dans un deuxième contexte de GUI, interprétant les données d'entrées tactiles en combinaison avec un contexte actuel de GUI afin de déterminer une commande appropriée pour le contexte actuel de GUI ; et

l'actualisation de la GUI en réponse à la commande appropriée, caractérisée en ce que le procédé comprend en outre l'envoi, à partir du dispositif contrôlé à distance (300), d'informations via un protocole de communication bidirectionnelle à la télécommande (200), informant cette dernière afin qu'elle affiche un clavier sur l'écran tactile, au moins partiellement en réponse aux informations reçues via le protocole de communication bidirectionnelle.

2. Système comprenant :

une télécommande (200) comprenant :

un écran tactile (202) configuré pour recevoir des entrées tactiles,

une unité de traitement pour recevoir les signaux électroniques en provenance de l'écran tactile et pour traduire les signaux en données d'entrées tactiles, et

une interface de communication configurée pour :

envoyer les données d'entrées tactiles à un dispositif commandé à distance (300), les données incluant au moins des paramètres de position, de mouvement et de durée, et

recevoir des informations en provenance du dispositif commandé à distance (300) via un protocole de communication bidirectionnelle demandant à la télécommande d'afficher un clavier, où la télécommande est configurée pour afficher un clavier sur l'écran tactile, au moins partiellement en réponse aux informations reçues via le protocole de communication bidirectionnelle ;

un dispositif commandé à distance (300) configuré pour présenter une interface graphique utilisateur dans multiples contextes,

le dispositif commandé à distance comprenant :

un affichage pour afficher l'interface graphique utilisateur(GUI),

une interface de communication interface configurée pour :

recevoir les données d'entrées tactiles, où les données d'entrées tactiles peuvent être interprétées par le dispositif commandé à distance (300) comme l'une des multiples commandes potentielles dans un premier contexte de GUI du dispositif commandé à distance (300) et comme une autre des multiples commandes potentielles dans un deuxième contexte de GUI, et

une unité de traitement configurée pour interpréter les données d'entrées tactiles en combinaison avec un contexte actuel de GUI pour déterminer une commande appropriée dans le contexte actuel, et pour actualiser la GUI en réponse à la commande appropriée,

caractérisé en ce que

l'interface de communication est configurée en outre pour :

envoyer des informations via un protocole de communication bidirectionnelle demandant à la télécommande d'afficher un clavier sur l'écran tactile au moins partiellement en réponse aux informations reçues via le protocole de communication bidirectionnelle.

3. Dispositif configuré avec une application ayant pour effet que le dispositif fonctionne comme une télécommande (200) pour un dispositif commandé à distance, comprenant :

un écran tactile (202) configuré pour recevoir une entrée tactile,

une entrée de traitement pour recevoir les signaux électroniques en provenance de l'écran tactile et pour traduire les signaux en données d'entrées tactiles, et

une interface de communication interface configurée pour :

envoyer les données d'entrées tactiles à un dispositif commandé à distance (300), les données incluant au moins des paramètres de position, de mouvement et de durée, où les données d'entrées tactiles peuvent être interprétées par le dispositif de commande à distance (300) comme l'une des multiples commandes potentielles dans un premier contexte d'interface graphique utilisateur (GUI) du dispositif de commande à distance (300) et comme une autre des multiples commandes potentielles dans un deuxième contexte de GUI,

où le dispositif commandé à distance est configuré pour interpréter les données d'entrées tactiles en combinaison avec le contexte actuel de la GUI pour déterminer une commande appropriée pour le contexte actuel, et pour actualiser la GUI en réponse à la commande appropriée,

caractérisé en ce que

l'interface de communication est en outre configurée pour :

recevoir des informations du dispositif commandé à distance (300) via un protocole de communication bidirectionnelle demandant à la télécommande d'afficher un clavier sur l'écran tactile, au moins partiellement en réponse aux informations reçues via le protocole de communication bidirectionnelle.

4. Dispositif configuré avec une application ayant pour effet que le dispositif fonctionne comme un dispositif commandé à distance (300) par une télécommande(200), comprenant :

un affichage pour afficher l'interface graphique utilisateur (GUI),

une interface de communication configurée pour :

recevoir des données d'entrées tactiles provenant d'une télécommande (200), les données incluant au moins des paramètres de position, de mouvement et de durée, où les données d'entrées tactiles peuvent être interprétées par le dispositif commandé à distance (300) comme l'une des multiples commandes potentielles dans un premier contexte d'interface graphique utilisateur (GUI) du dispositif commandé à distance (300) et comme une autre des multiples commandes potentielles dans un deuxième contexte de GUI,

une unité de traitement configurée pour interpréter les données d'entrées tactiles en combinaison avec un contexte actuel de GUI pour déterminer une commande appropriée dans le contexte actuel, et pour actualiser la GUI en réponse à la commande appropriée,

caractérisé en ce que

l'interface de communication est en outre configurée pour :

envoyer des informations via un protocole de communication bidirectionnelle demandant à la télécommande d'afficher un clavier sur l'écran tactile au moins partiellement en réponse aux informations reçues via le protocole de communication bidirectionnelle.

5. Programme informatique comprenant des instructions qui, lorsque le programme est exécuté par le système faisant l'objet de la revendication 2, permettent de réaliser le procédé faisant l'objet de la revendication 1.

6. Programme informatique comprenant des instructions qui, lorsque le programme est exécuté par un dispositif informatique comprenant un écran tactile, une unité de traitement pour recevoir les signaux électroniques provenant de l'écran tactile et une interface de communication,

ont pour effet que le dispositif informatique fonctionne comme une télécommande (200) pour un dispositif commandé à distance, de manière à ce que les instructions amènent le dispositif informatique à :

traduire le signal d'entrée tactile en provenance de l'écran tactile en données d'entrées tactiles,

envoyer les données d'entrées tactiles à un dispositif commandé à distance (300), les données incluant au moins des paramètres de position, de mouvement et de durée, où les données d'entrées tactiles peuvent être interprétées par le dispositif commandé à distance (300) comme l'une des multiples commandes potentielles dans un premier contexte d'interface graphique utilisateur (GUI) du dispositif commandé à distance (300) et comme une autre des multiples commandes potentielles dans un deuxième contexte de GUI,

où le dispositif commandé à distance est configuré pour interpréter les données d'entrées tactiles en combinaison avec le contexte actuel de la GUI pour déterminer une commande appropriée pour le contexte actuel, et pour actualiser la GUI en réponse à la commande appropriée,

caractérisé en ce que les instructions amènent par ailleurs le dispositif informatique à :

recevoir des informations en provenant du dispositif commandé à distance (300) via un protocole de communication bidirectionnelle demandant à la télécommande d'afficher un clavier sur l'écran tactile, au moins partiellement en réponse aux informations reçues via le protocole de communication bidirectionnelle.

7. Produit de programme informatique comprenant des instructions qui, lorsque le programme est exécuté par un dispositif informatique comprenant un affichage, une unité de traitement et une interface de communication, amènent le dispositif à fonctionner comme un dispositif commandé à distance (300) par une télécommande (200), dans la mesure où les instructions amènent le dispositif informatique à :

afficher une interface graphique utilisateur (GUI),

recevoir des données d'entrées tactiles provenant d'une télécommande (200), les données incluant au moins des paramètres de position, de mouvement et de durée, où les données d'entrées tactiles peuvent être interprétées par le dispositif commandé à distance (300) comme l'une des multiples commandes potentielles dans un premier contexte d'interface graphique utilisateur (GUI) du dispositif commandé à distance (300) et comme l'autre des multiples commandes potentielles dans un deuxième contexte de GUI,

interpréter les données d'entrées tactiles en combinaison avec un contexte actuel de la GUI pour déterminer la commande appropriée pour le contexte actuel, et actualiser la GUI en réponse à la commande appropriée,

caractérisé en ce que les instructions amènent en outre le dispositif informatique à :

envoyer des informations via un protocole de communication bidirectionnelle demandant à la télécommande d'afficher un clavier sur l'écran tactile, au moins partiellement en réponse aux informations reçues via le protocole de communication bidirectionnelle.

Abrégé

Télécommande tactile directionelle

R. 47(1)

Titre de l'invention

Le système et le procédé présentés sont particulièrement utiles pour commander un dispositif à distance avec un ou plusieurs menus via une interface tactile à distance comportant au moins une zone d'entrée principale non structurée. Un utilisateur peut fournir des entrées à une interface tactile sans avoir besoin de regarder l'interface et pourtant obtenir la réaction souhaitée de la part du dispositif commandé à distance. La zone d'entrée principale de l'interface tactile peut avoir ou ne pas avoir d'affichage de fond tel qu'un écran tactile type, mais la zone d'entrée principale devrait être une zone non structurée et ne devrait pas avoir d'éléments, de boutons, d'icônes ou d'équivalents pouvant être sélectionnés indépendamment. L'interface tactile n'étant pas structurée, l'utilisateur n'a pas à identifier de boutons pouvant être sélectionnés. Au contraire, il peut entrer un geste dans l'interface et regarder le dispositif commandé à distance réagir. Le système ne fournit aucune autre confirmation visuelle.